|

|

|---|

Correlação e regressão estão intimamente relacionadas. Na correlação estamos principalmente preocupados com os aspectos qualitativos das relações possíveis. A regressão preocupa-se com os aspectos quantitativos das relações, tais como determinar a inclinação e intercepto de uma linha reta que fornece um ajuste adequado para dados fornecidos. Caso o ajuste considerado adequado seja um polinômio de grau \(p\) é necessário fornecer valores para as \(p + 1\) constantes que determinam um polinômio de melhor ajuste. Há sim equivalência entre alguns aspectos das duas abordagens, por exemplo, em regressão linear um teste de inclinação zero é equivalente a um teste de correlação zero. Valores de \(+1\) ou \(-1\) para o coeficiente de correlação do produto de momentos da Pearson nos diz que todos os pontos observados estão em uma linha reta.

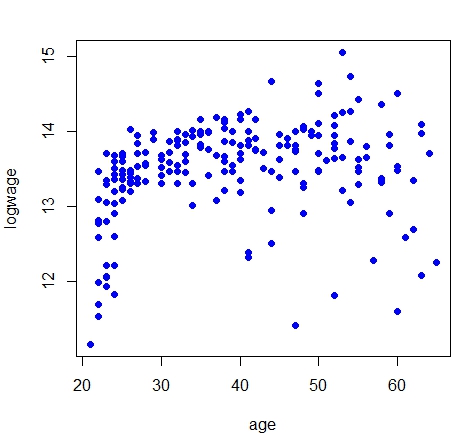

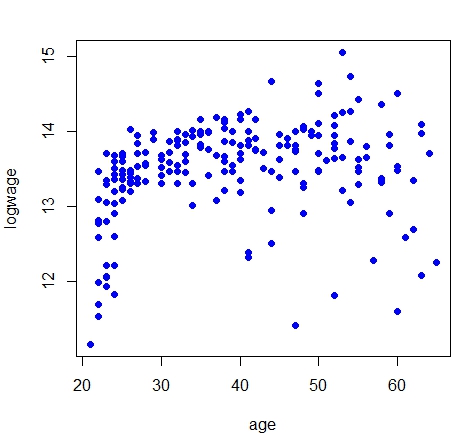

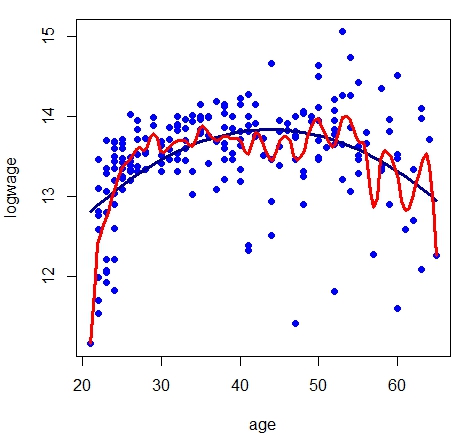

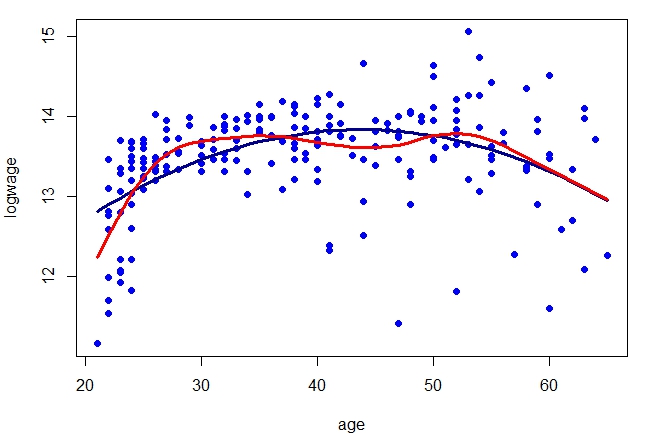

Estudaremos aqui a regressão não paramétrica e para isso vamos considerar \(n\) pares de observaçães \((x_1,Y_1),\cdots,(x_n,Y_n)\) como nas figuras abaixo. A variável aleatória resposta \(Y\) está relacionada à covariável determinística \(x\) pelas equações \begin{equation} Y_i \, = \, r(x_i)+\epsilon_i, \qquad \mbox{E}(\epsilon_i) \, = 0, \qquad i=1,2,\cdots,n, \end{equation} onde \(r\) é a função de regressão. A variável \(x\) também é chamada de recurso. Queremos estimar ou “aprender” a função \(r\) em hipóteses fracas. O estimador de \(r(x)\) é denotado por \(\widehat{r}_n(x)\). Também nos referimos a \(\widehat{r}_n(x)\) como um suavizador. A princípio, faremos a suposição simplificadora de que a variância \(\mbox{Var}(\epsilon_i) = \sigma^2\), ou seja, a variância de \(\epsilon_i\) não depende de \(x\). Vamos relaxar essa suposição mais tarde.

Na equação acima, estamos tratando os valores da covariável \(x_i\) como fixos. Poderíamos tratá-los como aleatórios, em cujo caso escrevemos os dados como \((X_1,Y_1),\cdots,(X_n,Y_n)\) e \(r(x)\) é então interpretado como a média de \(Y\) condicional em \(X = x\), isto é, \begin{equation} r(x) \, = \, \mbox{E}(Y \,| \, X=x)\cdot \end{equation} Há pouca diferença nas duas abordagens e, na maioria das vezes, adotamos a abordagem “fixo \(x\)”, exceto quando indicado.

|

|

|---|

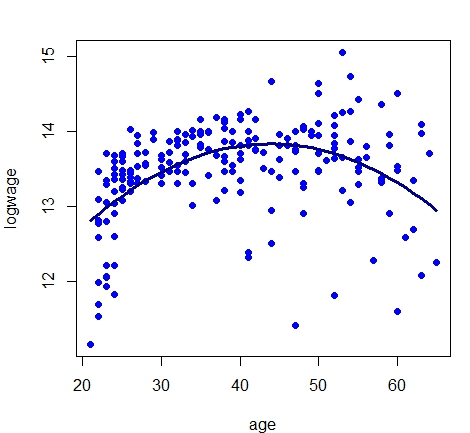

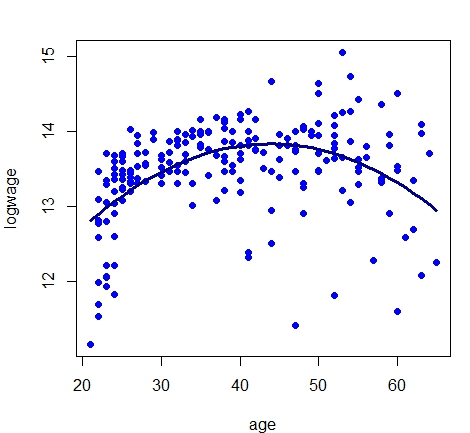

Nós temos medições ruidosas de \(Y_i\) e \(r(x_i)=10.0419+0.1731age-0.0019age^2\). Nosso objetivo é estimar \(r\) de forma não paramétrica. A variância \(\mbox{Var}(\epsilon_i)\) definitivamente não é constante como uma função de \(x\).

Os métodos que consideramos aqui são os métodos de regressão local e métodos de penalização. O primeiro inclui a regressão do kernel e a regressão polinomial local. Este último leva a métodos baseados em splines. Todos os estimadores considerados são suavizadores lineares.

Antes de mergulharmos na regressão não-paramétrica, primeiro revisamos brevemente a regressão linear ordinária e sua regressão logística relativa próxima.

Suponhamos temosos dados \((x_1,Y_1),\cdots,(x_n,Y_n)\) onde \(Y_i\in\mathbb{R}\) e \(x_i=(x_{i1},\cdots,x_{ip})^\top\in\mathbb{R}^p\). O modelo de regressão linear assume que \begin{equation} Y_i \, = \, r(x_i) \, + \, \epsilon_i \, = \, \sum_{k=1}^p \beta_kx_{ik} \, + \, \epsilon_i, \qquad i=1,\cdots,n, \end{equation} onde \(\mbox{E}(\epsilon_i)=0\) e \(\mbox{Var}(\epsilon_i)=\sigma^2\). Normalmente, queremos incluir um intercepto no modelo, então vamos adotar a convenção de que \(x_{i1} = 1\).

A matriz de planejamento \(X\) é uma matriz de dimensão \(n\times p\) definida por \begin{equation} X \, = \, \begin{pmatrix} x_{11} & x_{12} & \cdots & x_{1p} \\ x_{21} & x_{22} & \cdots & x_{2p} \\ \vdots & \vdots & \vdots & \vdots \\ x_{n1} & x_{n2} & \cdots & x_{np} \end{pmatrix}\cdot \end{equation} O conjunto \(\mathcal{L}\) de vetores que podem ser obtidos como combinações lineares das colunas de \(X\), é chamado de espaço de coluna de \(X\).

Seja \(Y_i=(Y_1,\cdots,Y_n)^\top\), \(\epsilon=(\epsilon_1,\cdots,\epsilon_n)^\top\) e \(\beta=(\beta_1,\cdots,\beta_p)^\top\). Podemos então escrever o modelo de regressão linear como \begin{equation} Y \, = \, X\beta \, + \, \epsilon\cdot \end{equation}

Os estimadores de mínimos quadrados \(\widehat{\beta}=(\widehat{\beta}_1,\cdots,\widehat{\beta}_p)^\top\) é o vetor que minimiza a soma de quadrados dos resíduos \begin{equation} (Y-X\beta)^\top (Y-X\beta) \, = \, \sum_{i=1}^n \left( Y_i - \sum_{k=1}^p x_{ik}\beta_k\right)^2\cdot \end{equation} Assumindo que \(X^\top X\) seja inversível, o estimador de mínimos quadrados é \begin{equation} \widehat{\beta} \, = \, (X^\top X)^{-1}X^\top Y\cdot \end{equation} O comando lm avalia esta expresão e, é desta forma que obtemos \(\widehat{\beta}_0=10.0419773\), \(\widehat{\beta}_1=0.1731310\) e \(\widehat{\beta}_2=-0.0019771\) com os dados do exemplo acima.

O estimador de \(r(x)\) no ponto \(x=(x_1,\cdots,x_p)^\top\) é então \begin{equation} \widehat{r}_n(x) \, = \, \sum_{k=1}^n \widehat{\beta}_kx_k \, = \, x^\top \widehat{\beta}\cdot \end{equation} Avaliando esta equação obtemos a curva estimada do logaritmo da renda anual segunda a idade do declarante, isto realizado com o auxílio do comando fitted.values aplicado no objeto model.par.

Segue-se que os valores ajustados \(\widehat{r}_n(x)=(\widehat{r}_n(x_1),\cdots,\widehat{r}_n(x_n))^\top\) podem ser escritos matricialmente como \begin{equation} \widehat{r}_n(x) \, = \, X\widehat{\beta} \, = \, HY, \end{equation} onde \begin{equation} H \, = \, X(X^\top X)^{-1}X^\top \end{equation} é chamada de matriz hapéu. Os elementos do vetor \(\widehat{\epsilon} = Y − \widehat{r}_n(x)\) são chamados de resíduos ordinários. A matriz chapéu é simétrica \(H = H^\top\) e idempotente, \(H^2 = H\). Segue-se que \(\widehat{r}_n(x)\) é a projeção de \(Y\) no espaço de colunas \(\mathcal{L}\) de \(X\). Pode-se mostrar que o número de parâmetros \(p\) está relacionado à matriz \(H\) pela equação \begin{equation} p \, = \, \mbox{tr}(H) \end{equation} onde \(\mbox{tr}(H)\) denota o traço da matriz \(H\), isto é a soma dos seus elementos na disgonal principal. Na regressão não paramétrica, o número de parâmetros será substituído pelos graus de liberdade efetivos que serão definidos através de uma equação como \(p \, = \, \mbox{tr}(H)\).

Dado qualquer \(x=(x_1,\cdots,x_p)^\top\), podemos escrever \begin{equation} \widehat{r}_n(x) \, = \, \mathcal{l}(x)^\top Y \, = \, \sum_{i=1}^n \mathcal{l}_i(x)Y_i, \end{equation} sendo que \begin{equation} \mathcal{l}(x)^\top \, = \, x^\top(X^\top X)^{-1}X^\top\cdot \end{equation}

Um estimador não viciado de \(\sigma^2\) é \begin{equation} \widehat{\sigma}^2 \, = \, \dfrac{1}{n-p}\sum_{i=1}^n\big( Y_i-\widehat{r}_n(x_i)\big)^2 \, = \, \dfrac{||\widehat{\epsilon}||}{n-p}\cdot \end{equation} Em seguida, construímos uma banda de confiança para \(\widehat{r}_n(x)\). Queremos encontrar um par de funções \(a(x)\) e \(b(x)\) tais que \begin{equation} P\Big( \big\{x\in\mathbb{R}^p \, : \, a(x)\leq \widehat{r}_n(x)\leq b(x), \, \forall \, x \big\}\Big) \geq 1-\alpha\cdot \end{equation}

Dado que \(\widehat{r}_n(x) \, = \, \sum_{i=1}^n \mathcal{l}_i(x)Y_i\), segue que \begin{equation} \mbox{Var}\big(\widehat{r}_n(x) \big) \, = \, \sigma^2 \sum_{i=1}^n \mathcal{l}_i^2(x) \, = \, \sigma^2||\mathcal{l}||^2, \end{equation} o qual sugere utilizarmos bandas de confiança da forma \begin{equation} I(x) \, = \, \big( a(x),b(x) \big) \, = \, \Big( \widehat{r}_n(x)-c\widehat{\sigma}||\mathcal{l}(x)||, \widehat{r}_n(x)+c\widehat{\sigma}||\mathcal{l}(x)||\Big), \end{equation} para alguma constante \(c\). O teorema a seguir pode ser encontrado em Scheffé (1959). Denotemos por \(F(p, n-p)\) a variável aleatória com distribuição \(F-Fisher\) com graus de liberdade \(p\) e \(n-p\). Seja \(F_\alpha(p, n−p)\) o \(\alpha\)-quantil superior para essa variável aleatória, ou seja, \(P\big(F(p,n-p)> F_\alpha(p,n-p)\big)= \alpha\).

Antes de passar para o procedimento anunciado aqui, olhamos brevemente para o modelo clássico de regressão de mínimos quadrados. Muitos leitores já estarão familiarizados com este modelo, mas enfatizamos aqui os aspectos que ajudam a entender a lógica por trás de muitas abordagens livres de distribuição. Na abordagem paramétrica clássica, assume-se que para cada um dos \(n\) conjuntos de \(x_i\) observados, que podem ser variáveis aleatórias ou um conjunto de valores fixos que podem ou não ser escolhidos antecipadamente, observamos algum valor \(y_i\) de uma variável aleatória \(Y_i\), que tem as propriedades que sua média depende, ou seja, é condicionada ao valor de \(x_i\) de tal forma que \begin{equation} \mbox{E}(Y_i|x_i) \, = \, \beta_0 + \beta_1 x_i, \end{equation} enquanto a variância de \(Y_i\) é independente de \(x\) e para todos os \(x_i\) tem o valor \begin{equation} \mbox{Var}(Y_i) \, = \, \sigma^2, \end{equation} onde \(\beta_0\), \(\beta_1\) e \(\sigma^2\) são desconhecidos. A relação linear entre \(\mbox{E}(Y|x)\) e \(x\) da forma \(\mbox{E}(Y|x) = \beta_0 + \beta_1x\) entre a média condicional de \(Y\) e \(x\) dado define a regressão de \(Y\) em \(x\). A linha tem inclinação \(\beta_1\) e intercepto \(\beta_0\) no eixo \(y\). A notação \(Y_i|x_i\) é a notação convencional para um evento ou variável \(Y_i\) tendo alguma propriedade condicionada a um \(x_i\) especificado.

Para muitos fins de inferência, assume-se também que a distribuição condicional de \(Y_i | x_i\) é \(N(\beta_0 + \beta_1x_i, \sigma^2)\). Um problema clássico de regressão é estimar \(\beta_0\), \(\beta_1\) e, às vezes, também \(\sigma^2\) dado um conjunto de \(n\) observações emparelhadas \((x_1, y_1), (x_2, y_2),\cdots ,(x_n, y_n)\) onde para um dado \(x_i\) o \(y_i\) é um valor observado da variável aleatória \(Y_i\). Estas condições são válidas se cada um \((x_i, y_i)\) satisfizer \begin{equation} y_i \, = \, \beta_0 + \beta_1x_i + \epsilon_i, \end{equation} onde cada \(\epsilon_i\) é um valor não observado de uma variável aleatória \(N(0,\sigma^2)\) e os \(\epsilon_i\) são independentes uns dos outros e também de \(x_i\). A estimativa de mínimos quadrados busca valores \(\widehat{\beta}_0\) e \(\widehat{\beta}_1\) que minimizem \begin{equation} S = \sum_{i=1}^n \big( y_i-\beta_0-\beta_ix_i\big)^2\cdot \end{equation} A linha reta \(y=\widehat{\beta}_0+\widehat{\beta}_1x\) é chamada de regressão de mínimos quadrados de \(y\) em \(x\). Se, para qualquer linha \(y=\beta_0+\beta_1x\), denotamos a coordenada \(y\) correspondente a \(x=x_i\) por \(\widehat{y}_i\), ou seja, \(\widehat{y}_i=\widehat{\beta}_0+\widehat{\beta}_1x_i\) então as diferenças entre os valores observados e previstos, isto é, \(\widehat{\epsilon}_i=y_i-\widehat{y}_i\), \(i=1,2,\cdots,n\) são chamados os resíduos absolutos com relação a essa linha.

Com os pressupostos acima da regressão clássica por mínimos quadrados é feita uma generalização de testes clássicos para comparação de médias de tratamento. Em particular, um teste de \(H_0: \, \beta_1=0\) equivale a um teste de igualdade de um conjunto de médias. Isso decorre de considerarmos os \(x_i\) como indicadores ou rótulos anexados às amostras. Se houver \(n\) observações emparelhadas \((x_i, y_i)\), cada \(y_i\) correspondente a um \(x_i\) particular pode ser encarado como um valor observado a partir da amostra marcada por esse \(x_i\). O número total de amostras \(m\) pode ser qualquer número entre 2 e \(n\) e o número de observações \(n_j\), na amostra \(j\), \(j = 1, 2,\cdots, m\) estão sujeitos à restrição \(n_1 + n_2 +\cdots + n_m = n\). Em particular, se não houver dois \(x_i\) iguais, existem \(n\) amostras, cada uma de uma observação e, no outro extremo, se houver apenas duas \(x_i\) distintas, há duas amostras com número observações \(n_1\) e \(n_2 = n-n_1\), respectivamente. Suponha que neste último caso marcamos a primeira amostra por \(x = 0\) e a segunda categoria por \(x = 1\) e os primeiros valores de amostra são \begin{equation} y_{11}, y_{12}, \cdots,y_{1n_1} \end{equation} com média \(\mu_0\) e os valores da segunda amostra sejam \begin{equation} y_{21}, y_{22}, \cdots,y_{2n_2} \end{equation} com média \(\mu_1\). Pode então ser mostrado que \(\widehat{\beta}_1 = \mu_1 - \mu_0\), a diferença de média amostral utilizada no teste \(t\) para a igualdade das médias dos tratamentos. Assim, o teste de igualdade de médias é neste caso idêntico ao teste \(H_0 \, : \, \beta_1 = 0\). No caso mais geral de \(m\) amostras, um teste para \(\beta_1 = 0\) é um teste para a identidade de todas as \(m\) médias populacionais.

É bem conhecido que para o modelo clássico de mínimos quadrados o estimador de \(\beta_1\) não depende do estimador de \(\beta_0\), mas o de \(\beta_0\) depende daquele de \(\beta_1\) através de \(\widehat{\beta}_1\), já que \(\widehat{\beta}_0 = \overline{y} - \widehat{\beta}_1\overline{x}\). A partir dessa expressão para \(\widehat{\beta}_0\) é facilmente visto que a equação ajustada pode ser escrita sem referência ao intercepto na forma \begin{equation} y \, = \, \overline{y}-\widehat{\beta}_1(x-\overline{x}), \end{equation} implicando que a linha passa pelo ponto \((\overline{x},\overline{y})\).

Uma interpretação gráfica disso é que a inclinação da linha ajustada é inalterada por uma mudança de origem. Em particular, se mudarmos a origem para a média bivariada \((\overline{x},\overline{y})\) e escrevermos \(\widetilde{x}= x - \overline{x}\), \(\widetilde{y} = y - \overline{y}\) a equação acima se torna \begin{equation} \widetilde{y} \, = \, \widehat{\beta}_1 \widetilde{x} \end{equation} e, então \begin{equation} \widehat{\beta}_1 \, = \, \frac{\displaystyle\sum_{1=1}^n \widetilde{x}_i\widetilde{y}_i}{\displaystyle\sum_{i=1}^n \widetilde{x}_i^2}\cdot \end{equation}

A expressão acima ainda é válida se apenas mudarmos a origem para a média dos \(x_i\) e usarmos o \(y_i\) original. Foi apontado que o coeficiente de correlação de Pearson permanece inalterado por transformações lineares de \((x, y)\) da forma \(x'= (x - k)/s\) e \(y' = (y - m)/t\) onde \(s\), \(t\) ambos são positivos. Acabamos de ver que, em regressão, embora a estimativa de \(\beta_0\) seja afetada por uma mudança na origem, a de \(\beta_1\) não é, isto é, transformações da forma \(x'= (x - k)\), \(y' = (y - m)\) não afetam a estimativa de \(\beta_1\). Entretanto, é fácil estabelecer que a transformação \(x'= (x - k)/s\) e \(y' = (y - m)/t\) altera tanto o valor verdadeiro de \(\beta_1\) quanto sua estimativa de mínimos quadrados pelo mesmo fator de escala \(s/t\), alterando \(\beta_1\) para \(\beta_1'= s\beta_1/t\).

No entanto, faremos uso de outra propriedade do coeficiente de correlação de Pearson em testes permutacionais, ou seja, porque todas as outras quantidades na expressão da estimativa do coeficiente de correlação de Pearson permanecem constantes sob permutações, podemos basear testes de permutação na estatística \(T = \sum_i x_iy_i\) no caso do coeficiente de Pearson como alternativa ao uso do coeficiente de correlação amostral \(r\). Uma propriedade correspondente é transferida para o coeficiente de Spearman com postos substituindo os \(x_i\), \(y_i\).

Descartando a suposição de normalidade para o \(Y_i\), fazer inferências sobre \(\beta_0\) e \(\beta_1\) são difíceis, então consideramos primeiro a estimação apenas de \(\beta_1\). O problema reduz-se então a fazer inferências sobre diferenças em medianas ou médias amostrais marcadas pelos diferentes \(x_i\). Para qualquer \(Y_i,Y_j\) independentes, associados com \(x_i,x_j\) distintos, descartamos as suposições de normalidade nas distribuições condicionais de \(Y | x\) e assumimos agora apenas que para qualquer \(x_i, x_j\) elas têm distribuições \(F_i (Y_i | x_i)\), \(F_j (Y_j | x_j)\) que diferem apenas na sua medida de centralidade que será tomada em geral como a mediana, mas que coincidirá com a média das distribuições condicionais que são assumidas simétricas, desde que a média exista. Para o modelo de regressão linear, a mediana de \(F_i(Y_i|x_i)\) é \(\mbox{Mediana}(Y_i|x_i)=\beta_0+\beta_1 x_i\) e aquela de \(F_j(Y_j|x_j)\) é \(\mbox{Mediana}(Y_j|x_j)=\beta_0+\beta_1 x_j\), sendo estes os análogos da estimativa do coeficiente de correlação e a diferença entre as medianas é claramente \begin{equation} \mbox{Mediana}(Y_j-Y_i|x_i,x_j)=\beta_1 (x_j-x_i)\cdot \end{equation}

Assumindo que as diferenças entre as distribuições estão confinadas a uma diferença mediana implica que, para todo \(i\) \begin{equation} D_i(\beta_1) = Y_i-\beta_1x_i, \end{equation} são distribuídas de forma idêntica e independente com mediana \(\beta_0\). Como os \(D_i\) são, portanto, independentes do \(x_i\), segue-se que eles não são correlacionados com o \(x_i\). Como apontamos, o \(x_i\) pode ser alterado pela adição ou subtração de uma constante sem afetar a inclinação ou sua estimativa. Em particular, ele simplificará a álgebra se ajustarmos o \(x_i\) adicionando uma constante apropriada para fazer \(\sum_i x_i = 0\), o que, em termos gráficos, implica mudar a origem para um ponto no eixo \(x\) correspondente à média \(\overline{x}\). Escrevendo \(\widehat{D}_i = y_i - \beta x_i\) um teste intuitivamente razoável da hipótese \(H_0 \, : \, \beta_1 = \beta\) contra uma alternativa de um ou dois lados é um teste para a correlação zero entre o \(x_i\) e o \(\widehat{D}_i\), pois sabemos que se \(H_0\) é válido então \(D_i(\beta)\) não é correlacionado com o \(x_i\) e os \(\widehat{D}_i\) são valores observados da variável \(D_i(\beta)\). Se o teste mais apropriado é baseado em Pearson, Spearman, Kendall ou algum outro coeficiente dependerá de quais suposições sejam feitas sobre as características da distribuição \(F(Y|x)\), por exemplo, cauda longa, simétrica ou assimétrica, etc.. Nós chamamos os \(\widehat{D}_i\) de resíduos por conveniência, mas este é um uso não ortodoxo do termo que mais convencionalmente se refere ao \(\widehat{\epsilon}_i = y_i - \alpha - \beta x_i\) onde \(\alpha\) é algum valor hipotético de \(\beta_0\). Uma estatística apropriada baseada no coeficiente de Pearson para o teste de correlação zero é \begin{equation} T(\beta) \, = \, \sum_{i=1}^n x_i\widehat{D}_i \, = \, \sum_{i=1}^n x_i (y_i - \beta x_i)\cdot \end{equation}

Devemos lembrar que se tivermos medições em duas variáveis para uma amostra de \(n\) indivíduos, estas observações emparelhadas podem ser escritas como \((x_1, y_1), (x_2, y_2),\cdots , (x_n, y_n)\). O coeficiente de correlação amostral de produto de momentos de Pearson \(r\), é definido como \begin{equation} r \, = \, \frac{\sum_i\Big( (x_i-\overline{x})(y_i - \overline{y})\Big)}{\sqrt{\sum_i (x_i-\overline{x})^2\sum_i(y_i-\overline{y})^2}}, \end{equation} que, para fins computacionais, é geralmente reordenada e escrita como \begin{equation} r \, = \, \frac{C_{xy}}{\sqrt{C_{xx}C_{yy}}}, \end{equation} sendo \(C_{xy}=\sum_i x_iy_i-(\sum_i x_i)(\sum_i y_i)/n\), \(C_{xx}=\sum_i x_i^2-(\sum_i x_i)^2/n\) e \(C_{yy}=\sum_i y_i^2-(\sum_i y_i)^2/n\).

Voltando ao nosso desenvolvimento. Observemos que, para estimar \(\beta\), um procedimento de estimação intuitivamente razoável é resolver para \(\beta\) a equação \begin{equation} T(\beta) \, - \, \sum_{i=1}^n x_i \sum_{i=1}^n \widehat{D}_i/n \, = \, 0\cdot \end{equation} Isso segue da forma de \(C_{xy}\), já que equalizar \(C_{xy}\) a zero garante um valor zero para o coeficiente de correlação amostral, uma vez que torna o numerador do coeficiente de correlação amostral de Pearson zero. Lembrando que podemos ajustar o \(x_i\) para ter a média zero, ou seja, de modo que \(\sum_i x_i = 0\) sem afetar nossa estimativa de \(\beta\), assumimos que isso foi feito para que a equação acima simplifique para \begin{equation} T(\beta) \, = \, \sum_{i=1}^n x_i( y_i - \beta x_i) \, = \, 0, \end{equation} com solução \(\widehat{\beta}=(\sum_i x_i y_i)/(\sum_i x_i^2)\).

Não fizemos suposições sobre a distribuição do \(D_i\) exceto que eles são idênticos para todos os \(i\), de modo que, para o teste de hipótese, um teste de permutação para o coeficiente de correlação de Pearson ser zero com base nos valores amostrais \((x_i, \widehat{D}_i)\) é apropriado. Como indicamos em outros casos, uma dificuldade com inferências baseadas em dados brutos usando um teste de permutação é que os resultados tendem a ser similares àqueles baseados na teoria equivalente, assumindo normalidade mesmo quando a suposição de normalidade é claramente violada. Em outras palavras, o método não tem robustez. Melhores procedimentos para lidar com dados são geralmente fornecidos por procedimentos de estimação baseados em classificação.

Vejamos como fazer inferências baseadas no coeficiente \(\tau_K\) de Kendall, sabemos que \(\tau_K\) depende apenas da ordem das observações e não da magnitude das diferenças entre os valores dos dados. Além disso, não há vantagem em ajustar o \(x_i\) para terem média zero. Simplifica a apresentação sem perda de generalidade se, quando os \(x_i\) são todos diferentes, assumimos que \(x_1 < x_2 \cdots < x_n\).

A estatística usada para inferência sobre \(\beta\) é \begin{equation} T_t(\beta) \, = \, \sum_i \mbox{sgn}\big( \widehat{D}_{ij}(\beta)\big), \end{equation} onde \begin{equation} \begin{array}{rcl} \widehat{D}_{ij}(\beta) & = & (y_j - \widehat{\beta}_0 - \widehat{\beta} x_j) - (y_i - \widehat{\beta}_0 - \widehat{\beta} x_i) \, = \, (y_j - \widehat{\beta} x_j) - (y_i - \widehat{\beta} x_i) \\ & = & \widehat{D}_{j} - \widehat{D}_{i} \, = \, (y_j - y_i) - \widehat{\beta}(x_j - x_i) \end{array} \end{equation} e e soma dos sinais dos \(\widehat{D}_{ij}\) é sobre todo \(i=1,2,\cdots,n-1\) e \(j> i\). Como os \(x_i\) são todos diferentes e em ordem ascendente é claro que \(T_t(\beta)\) é o numerador na expressão da estatística de teste para verificar nulidade do coeficiente \(\tau_K\) composto dos números de concordâncias menos o número de discordâncias nos pares de dados \((x_i,\widehat{D}_i)\).

O uso de uma estatística equivalente a \(T_t(\beta)\) foi proposto pela primeira vez por Theil (1950) e o procedimento é amplamente conhecido como o método de Theil. Sen (1968) destacou a relação com o coeficiente \(\tau_K\) de Kendall, então nos referimos a ele como o método Theil-Kendall ou estimador Theil-Sen.

Claramente \(T_t(\beta)\) é uma função linear do estimador amostral de \(\tau_K\) e um estimador de pontual apropriado de \(\beta\) é obtido ajustando-se \(T_t(\beta) = 0\). Como os \(x_i\) estão em ordem ascendente é fácil ver que \(T_t(\beta)\) não é alterada se substituirmos \(\widehat{D}_{ij}(\beta)\) por \(\widehat{B}_{ij} - \beta\) onde, \(\widehat{B}_{ij} = (y_j - y_i)/(x_j - x_i)\). Claramente, então, \(T_t(\beta) = 0\), se escolhermos \(\beta = mediana(\widehat{B}_{ij})\), então o número de positivos e o número de \(\widehat{D}_{ij}\) negativos serão iguais.

Como foi o caso de \(T_s(\beta)\), percebemos que apenas \(T_t(\beta)\) muda de valor quando \(\beta\) passa por um valor de \(\widehat{B}_{ij}\) e como a estatística é o numerador do coeficiente \(\tau_K\) de Kendall, segue-se que se todos os \(\widehat{B}_{ij}\) são distintos quando \(\beta\) aumenta de \(-\infty\) para \(\infty\), \(T_t(\beta)\) é uma função degrau decrescente por passos de 2 desde ½\( n(n-1)\) para -½\(n(n - 1)\). Claramente a divisão de \(T_t(\beta)\) por ½\( n(n-1)\) leva ao \(t_K\) de Kendall, que pode ser usado como uma estatística equivalente. Se os \(\widehat{D}_{ij}\) não forem todos distintos, alguns dos passos serão múltiplos de 2. Em particular, se um \(\widehat{D}_{ij}\) ocorre \(r\) vezes, ele induz um degrau de altura \(2r\). O valor de \(T_t(\beta)\) em qualquer \(\widehat{D}_{ij}\) pode ser considerado como a m&eacudia;dia dos valores imediatamente acima e abaixo daquele \(\widehat{D}_{ij}\).

Testes de hipóteses sobre \(\beta\) são diretos usando ou o \(t_K\) de Kendall ou o equivalente \(T_t(\beta)\) como a estatística de teste e se sabemos a distribuição exata do coeficiente de Kendall amostral quando \(\tau_K = 0\), um intervalo de confiança para \(\beta\) pode ser obtido. Os procedimentos estão ilustrados no Exemplo a seguir.

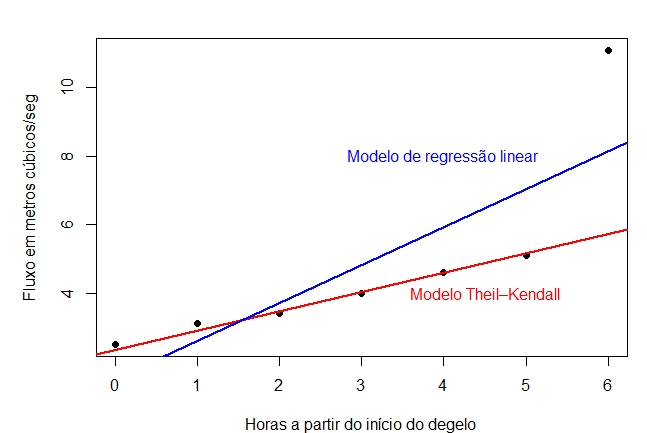

| Horas a partir do início do degelo \(x\) | 0 | 1 | 2 | 3 | 4 | 5 | 6 | ||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Fluxo em metros cúbicos/seg \(y\) | 2.5 | 3.1 | 3.4 | 4.0 | 4.6 | 5.1 | 11.1 | ||||||||

Primeiro vamos ajustar o modelo de regressão de Theil-Kendall ou Theil-Sen, para isso utilizamos a função mblm no pacote homônimo.

No gráfico a seguir mostramos o comportamento do modelo de regressão linear assim como do modelo não paramémetrico de Theil-Kendall ou Theil-Sen.

|

|---|

A regressão de Kendall-Theil é uma abordagem completamente não-paramétrica à regressão linear, onde existe uma variável independente e uma variável dependente. É robusto para outliers na variável dependente, como podemos perceber. Ele simplesmente calcula todas as linhas entre cada par de pontos e usa a mediana das inclinações dessas linhas. O método produz um declive e um intercepto para a linha de ajuste, assim como um p-valor para a inclinação também pode ser determinado. Normalmente, nenhuma medida análoga ao \(R^2\) é relatada. Na Seção IV.2.1 Avaliando a qualidade do ajuste, estudaremos uma forma alternativa de escrever \(R^2\) que poderemos utilizar nesta situação.

Para testar a hipótese em (i), observemos que inspeção mostra que a estimativa pontual de \(\beta_1\), ou seja, \(\mbox{mediana}(\widehat{B}_{ij})\) é 0.567, porque há dez maiores e dez menores \(\widehat{B}_{ij}\).

Para testar a hipótese \(\beta_1 = 1\) subtraímos \(\beta_1 = 1\) de cada \(\widehat{B}_{ij}\)

O pacote SuppDists incorpora ao R diversas distribuições suplementares, entre elas, a distribuição exata do coeficiente de correlação \(\tau_K\) de Kendall. Utilizamos as linhas de comando acima para avaliarmos evidências a favor ou contra \(H_0\). Correspondendo a este valor de \(t_K\) com \(N=7\), os sete pares de dados, o \(p-valor = 0.1361111\) é exatamente bilateral de modo que não há evidência convincente contra \(H_0\).

Para obter um intervalo de confiança aproximado de 95 por cento para \(\beta_1\), devemos primeiro determinar um valor de \(|T_t|\) com cauda o mais próxima possível, mas não superior a 0.025.

A estreita relação entre o \(\tau_K\) de Kendall e o \(T_t\) facilita o transporte de aproximações assintóticas entre eles. Usando os resultados para \(\tau_K\) pode-se mostrar (Maritz, 1995) que \begin{equation} \mbox{E}(T_t) = 0 \qquad \mbox{ e que } \qquad \mbox{Var}(T_t) = \frac{n (n - 1) (2n + 5)}{18}\cdot \end{equation} Para grandes \(n\) a distribuição de \(Z = T_t / \sqrt{\mbox{Var}(T_t)}\) é aproximadamente normal e inferências assintóticas podem então ser feitas da maneira usual. Mesmo para \(n = 7\), a aproximação às vezes não é seriamente enganosa, mas recomenda-se cautela com uma amostra tão pequena.

A regressão de Kendall-Theil também chamada de regressão de Theil-Sen é uma robusta substituição não-paramétrica da abordagem tradicional de mínimos quadrados ao modelo de regressão de linha reta \(Y = \beta_0 + \beta_1x + \epsilon\) e também a alguns modelos de regressão linear mais complexos. Esta metodologia não exige normalidade dos erros aleatórios, sendo capaz de fornecer estimativas dos parâmetros, testes de hipóteses lineares sobre os parâmetros, bem como intervalos de confiança para os parâmetros. Ver, por exemplo, Hollander, M. et. all. (2014) para uma descrição mais detalhada do método.

Como observamos anteriormente, todos os estimadores não-paramétricos aqui considerados são suavizadores lineares. A definição formal é a seguinte.

Definindo o vetor de valores ajustados \begin{equation} \widehat{r}_n(x) \, = \, \big( \widehat{r}_n(x_1),\cdots,\widehat{r}_n(x_n)\big)^\top, \end{equation} segue-se então que \begin{equation} \widehat{r}_n(x) \, = \, LY, \end{equation} onde \(L\) é uma matriz \(n\times n\) cuja \(i\)-ésima linha é \(\mathcal{l}_i(x)^\top\), assim, \(L_{ij} = \mathcal{l}_j(x_i)\). As entradas da \(i\)-ésima linha mostram os pesos dados a cada \(Y_i\) na formação da estimativa \(\widehat{r}_n(x_i)\).

O leitor não deve confundir suavizadores lineares com regressão linear, em que se assume que a função de regressão \(r(x)\) é linear. Devemos observar que os pesos em todos os suavizadores que usaremos terão a propriedade que, para todo \(x\), \(\sum_{i=1}^n \mathcal{l}_i(x) = 1\). Isto implica que o suavizador preserva curvas constantes, portanto, se \(Y_i = c\) para todo \(i\), então \(\widehat{r}_n(x) = c\).

|

|

|---|

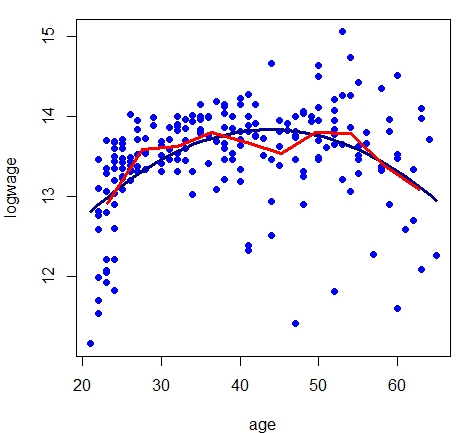

Vamos utilizar os dados do Exemplo IV.1 com os resultados do modelo de regressão linear. Para construir as figuras acima fizemos alterações ao comando regressogram disponível no pacote de funções HoRM. Como padrão a função regressogram devolve o gráfico de dispersão e a curva de regressão não paramétrica estimada pelo suavizamento linear. Como mostramos nas linhas de comando a seguir.

Com estes comandos obtemos duas figuras mostrando o ajuste de regressograma com \(m=10\) e \(m=20\) caixas, respectivamente. Isto foi obtido modificando o valor da opção \(nbins\). Um problema é que gostariamos de apresentar conjuntamente com o regressograma o ajuste do modelo de regressão paramétrico. Como isso não é possível modificamos apropriadamente a função segundo nosso interesse, como mostramos a seguir.

Podemos perceber com este exemplo que o regressograma aproxima-se do modelo paramétrico, embora o regressograma sirva mais como descrição dos dados e não como interpretação. O regressograma não é a única forma de encontrarmos um suavizamento linear. Vejamos no seguinte exemplo uma outra forma de definirmos um destes modelos.

É desejável usar uma medida, livre de unidade, para mensurar a adequação de modelos de regressão não paramétricos que seja comparável àquela usada para modelos de regressão paramétrica, a saber, \(R^2\). Note que esta será uma medida dentro da amostra da qualidade de ajuste. Dadas as desvantagens conhecidas de computar \(R^2\) com base na decomposição da soma dos quadrados, há uma definição e um método alternativos para calcular \(R^2\), que pode ser usado diretamente para qualquer modelo, linear ou não linear.

Esta medida estará sempre no intervalo \([0,1]\) com o valor 1 denotando um ajuste perfeito aos dados da amostra e 0 denotando nenhum poder preditivo acima daquele dado pela média incondicional da resposta. Pode ser demonstrado que este método de cálculo do \(R^2\) é idêntico à medida padrão computada como \(\sum_{i=1}^n (\widehat{\mu}_i-\overline{y})^2/\sum_{i=1}^n (y_i-\overline{y})^2\) quando o modelo é linear, obtido por mínimos quadrados e incluindo o termo do intercepto. Nesta expressão \(\widehat{\mu}=X\widehat{\beta}\) é o vetor de estimativas do preditor linear.

Esta medida útil permitirá a comparação direta entre a adequação da amostra e a qualificação óbvia de que este não é, de forma alguma, um critério de seleção de modelos e sim simplesmente uma medida resumida que podemos relatar.

Devemos observar que em situações nas quais agrupamos informações, como é o caso do regressograma, não é possível utilizarmos este coeficiente.

Os suavizadores que usaremos dependerão de algum parâmetro de suavização e precisaremos de alguma maneira de escolher \(h\). Definamos o risco como o erro quadrático médio \begin{equation} R(h) \, = \, \mbox{E}\Big( \frac{1}{n}\sum_{i=1}^n \big( \widehat{r}_n(x_i)-r(x_i)\big)^2 \Big)\cdot \end{equation}

Idealmente, gostaríamos de escolher \(h\) como aquele que minimizar \(R(h)\), mas \(R(h)\) depende da funç:ão desconhecida \(r(x)\). Em vez disso, minimizaremos uma estimativa \(\widehat{R}(h)\) de \(R(h)\). Como primeiro palpite, podemos usar a média da soma de quadrados dos resíduos, também chamadas de erro de treinamento \begin{equation} \frac{1}{n}\sum_{i=1}^n \big( Y_i-\widehat{r}_n(x_i)\big)^2 \end{equation} para estimar \(R(h)\). Isto acaba por ser uma estimativa pobre de \(R(h)\): é tendenciosa para baixo e tipicamente leva a subsuavizamento (sobreajuste). A razão é que estamos usando os dados duas vezes: para estimar a função e estimar o risco. A estimativa de função é escolhida para fazer \(\sum_{i=1}^n \big( Y_i-\widehat{r}_n(x_i)\big)^2\) pequeno, o que tenderá a subestimar o risco.

Estimaremos o risco usando validação cruzada, que é definida da seguinte forma.

Como dito acima, esta definição está incompleta. Nós não dissemos o que queremos dizer precisamente por \(\widehat{r}_{-i}\). Vamos definir \begin{equation} \widehat{r}_{-i}(x) \, = \, \sum_{j=1}^n Y_j\mathcal{l}_{j,(-i)}(x), \end{equation} onde \begin{equation} \mathcal{l}_{j,(-i)}(x) \, = \, \left\{ \begin{array}{cc} 0, & \mbox{ se } j = i \\ \frac{\displaystyle\mathcal{l}_j(x)}{\displaystyle\sum_{k\neq i} \mathcal{l}_k(x)}, & \mbox{ se } j\neq i \end{array}\right.\cdot \end{equation}

Em outras palavras, definimos o peso em \(x_i\) para 0 e renormalizamos os outros pesos para somar um. Para todos os métodos a serem considerados: regressão kernel, polinômios locais e suavização por splines, essa forma para \(\widehat{r}_{-i}\) pode realmente ser derivada como uma propriedade do método, em vez de uma questão de definição. Mas é mais simples tratar isso como uma definição.

A intuição da validação cruzada é a seguinte. Observe que \begin{equation} \begin{array}{rcl} \mbox{E}\big( Y_i-\widehat{r}_{-i}(x_i)\big)^2 & = & \mbox{E}\big( Y_i-r(x_i)+r(x_i)-\widehat{r}_{-i}(x_i)\big)^2 \\ & = & \sigma^2 \, + \, \mbox{E}\big( r(x_i)-\widehat{r}_{-i}(x_i)\big)^2 \, \approx \, \sigma^2 \, + \, \mbox{E}\big( r(x_i)-\widehat{r}_n(x_i)\big)^2, \end{array} \end{equation} e, portanto, \begin{equation} \mbox{E}(\widehat{R}) \, \approx \, R \, + \, \sigma^2 \, = \, \mbox{risco preditivo}\cdot \end{equation} Assim, o escore de validação cruzada é uma estimativa quase imparcial do risco.

Parece que pode ser demorado avaliar \(\widehat{R}(h)\), já que aparentemente precisamos recomputar o estimador após abandonar cada observação. Felizmente, existe uma fórmula de atalho para calcular \(\widehat{R}\) para suavizadores lineares e apresentada no seguinte teorema.

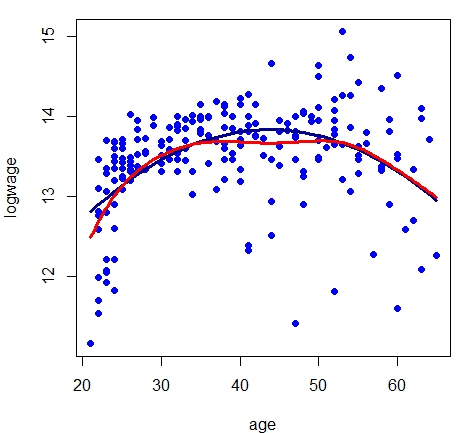

O parâmetro de suavização \(h\) pode ser escolhido minimizando \(\widehat{R}(h)\). É importante notar que não podemos supor que \(\widehat{R}(h)\) sempre tenha um mínimo bem definido. Devemos sempre traçar \(\widehat{R}(h)\) como uma função de \(h\). Embora interessante, não será desta maneira que encontraremos o valor estimado do parâmetro de suavização.

Em vez de minimizar o escore de validação cruzada, uma alternativa é usar uma aproximação chamada validação cruzada generalizada na qual cada \(L_{ii}\) na equação do Teorema IV.2 é substituída por sua média \(\frac{1}{n}\sum_{i=1}^n L_{ii} = \nu/n\) onde \(\nu = \mbox{tr}(L)\) são os graus efetivos de liberdade. Assim, nós minimizaríamos \begin{equation} GCV(h) \, = \, \frac{1}{n}\sum_{i=1}^n \frac{1}{n}\sum_{i=1}^n \Big( \frac{Y_i-\widehat{r}_n(x_i)}{1-\nu/n}\Big)^2 \cdot \end{equation} Geralmente, a largura de banda \(\widehat{h}\) que minimiza o escore de validação cruzada generalizada está próximo da largura de banda que minimiza a validação cruzada.

Utilizando a aproximação \((1-x)^{-2} \approx 1+2x\) vemos que \begin{equation} GCV(h) \, \approx \, \frac{1}{n}\sum_{i=1}^n \big( Y_i-\widehat{r}_n(x_i)\big)^2 \, + \, \frac{2\nu\widehat{\sigma}^2}{n} \, = \, C_p, \end{equation} onde \(\widehat{\sigma}^2=n^{-1}\sum_{i=1}^n \big( Y_i-\widehat{r}_n(x_i)\big)^2\). A equação acima é conhecida como a estatística \(C_p\) a qual foi originalmente proposta por Colin Mallows como critério para selecionar variáveis nos modelos de regressão linear. Mais geralmente, muitos critérios comuns de seleção de largura de banda podem ser escritos na forma \begin{equation} B(h) \, = \, \mathcal{D}(n,h)\times \frac{1}{n}\sum_{i=1}^n \big( Y_i-\widehat{r}_n(x_i)\big)^2, \end{equation} para diferentes escolhas de \(\mathcal{D}(n,h)\). Veja Härdle et al. (1988) para detalhes. Além disso, Härdle et al. (1988) provou, sob condições adequadas, os seguintes fatos sobre o valor de \(\widehat{h}\) que minimiza \(B(h)\). Seja \(\widehat{h}_0\) o valor de \(\widehat{h}\) que minimiza a perda \(L(\widehat{h}) = n^{-1}\sum_{i=1}^n \big(\widehat{r}_n(x_i)-r(x_i)\big)^2\), e seja \(h_0\) risco mínimo. Então para todo \(\widehat{h}\), \(\widehat{h}_0\) e \(h_0\) tendem a 0 na taxa \(n^{−1/5}\). Além disso, para certas constantes positivas \(C_1\), \(C_2\), \(\sigma_1\) e \(\sigma_2\), temos que \begin{equation} \begin{array}{cc} n^{3/10}\big(\widehat{h}-\widehat{h}_0\big) \, \approx \, N(0,\sigma_1^2), & \qquad n\big(L(\widehat{h})-L(\widehat{h}_0)\big) \, \approx \, C_1\chi_1^2 \\ n^{3/10}\big(h_0-\widehat{h}_0\big) \, \approx \, N(0,\sigma_2^2), & \qquad n\big(L(h_0)-L(\widehat{h}_0)\big) \, \approx \, C_2\chi_1^2 \cdot \end{array} \end{equation}

Assim, a taxa relativa de convergência de \(\widehat{h}\) é \begin{equation} \frac{\widehat{h}-\widehat{h}_0}{\widehat{h}_0} \, = \, O_P\Big(\frac{n^{3/10}}{n^{1/5}} \Big) \, = \, O_P(n^{-1/10})\cdot \end{equation} Essa taxa lenta mostra que é difícil estimar a largura de banda. Essa taxa é intrínseca ao problema de seleção de largura de banda, já que também é verdade que \begin{equation} \frac{\widehat{h}_0-h_0}{h_0} \, = \, O_P\Big(\frac{n^{3/10}}{n^{1/5}} \Big) \, = \, O_P(n^{-1/10})\cdot \end{equation}

Agora nos voltamos para a regressão não paramétrica local. Suponha que \(x_i\in\mathbb{R}\) seja escalar e considere o modelo de regressão no qual a variável resposta \(Y_i\) está relacionada com a covariável pela equação \begin{equation} Y_i \, = \, r(x_i) \, + \, \epsilon_i, \end{equation} onde \(\mbox{E}(\epsilon_i)=0\), \(i=1,2,\cdots,n\). Nesta seção, consideramos os estimadores de \(r(x)\) obtidos pela média ponderada dos \(Y_i\), dando maior peso àqueles pontos próximos de \(x\). Começamos com o estimador de regressão Kernel.

O estimador de média local no Exemplo IV.3 é um particular estimador Kernel Nadaraya–Watson. Segundo esta definição para encontrarmos estes estimadores somente faltaria encontrar qual deve ser o valor da largura de banda \(h\), mas fixando-a temos completamente definidos os pesos \(\mathcal{l}_i(x)\) e, portanto, o estimador \(\widehat{r}_n\).

|

|---|

Observe que o \(R^2\) no caso paramétrico foi 0.2231529, aumentando um pouco no caso não paramétrico para \(0.3108675\).

A escolha do kernel não é muito importante. As estimativas obtidas usando kernels diferentes são geralmente numericamente muito semelhantes. Esta observação é confirmada por cálculos teóricos que mostram que o risco é muito insensível à escolha do kernel; veja Seção 6.2.3 de Scott (1992). Então mostramos o resultado utilizando o kernel gaussiano, que é padrão do comando. Com esta observação vemos que especificar ou não o kernel não é muito importante.

O que importa muito mais é a escolha da largura de banda \(h\), que controla a quantidade de suavização. Larguras de banda pequenas fornecem estimativas muito aproximadas, enquanto larguras de banda maiores fornecem estimativas mais suaves. Em geral, vamos deixar a largura de banda depender do tamanho da amostra, então às vezes escrevemos \(h_n\).

O teorema a seguir mostra como a largura de banda afeta o estimador. Para declarar estes resultados, precisamos fazer alguma suposição sobre o comportamento de \(x_1,\cdots,x_n\) quando \(n\) aumenta. Para os propósitos do teorema, assumiremos que estes são escolhidos aleatoriamente de alguma densidade \(f\).

O primeiro termo no Teorema IV.3 é o viés ao quadrado e o segundo termo é a variância. O que é especialmente notável é a presença do termo \begin{equation} 2r'(x)\frac{f'(x)}{f(x)} \end{equation} no viés. Chamamos esta expressão de viés de design, pois depende do design, ou seja, a distribuição dos \(x_i\). Isso significa que o viés é sensível à posição dos \(x_i\). Além disso, pode-se mostrar que os estimadores de kernel também possuem alta tendência perto dos limites. Isso é conhecido como viés de limite. Veremos que podemos reduzir esses vieses usando um refinamento chamado regressão polinomial local.

Se diferenciarmos a expresão no Teorema IV.3 e definirmos o resultado igual a 0, veremos que a largura de banda ideal \(h_*\) é \begin{equation} h_* \, = \, \Big(\frac{1}{n}\Big)^{1/5}\left( \dfrac{\displaystyle \sigma^2\int K^2(x)\mbox{d}x \int \frac{1}{f(x)}\mbox{d}x} {\displaystyle \left(\int x^2K(x)\mbox{d}x \right)^2 \int \left(r''(x)+2r'(x)\frac{f'(x)}{f(x)} \right)^2 \mbox{d}x}\right)^{1/5}\cdot \end{equation} Assim, \(h_*= O(n^{-1/5})\). Colocando \(h_*\) de volta na expresão do Teorema IV.3, vemos que o risco diminui na taxa \(O(n^{−4/5})\). Na maioria dos modelos paramétricos, o risco do estimador de máxima verossimilhança diminui para 0 na taxa \(1/n\). A taxa mais lenta \(n^{−4/5}\) é o preço de usar métodos não paramétricos. Na prática, não podemos usar a largura de banda dada acima, já que \(h_*\) depende da função desconhecida \(r\). Em vez disso, usamos a validação cruzada, conforme descrito no Teorema IV.2.

Os estimadores de kernel sofrem de viés de limite e viés de design. Esses problemas podem ser aliviados usando uma generalização da regressão kernel chamada de regressão polinomial local.

Para motivar este estimador, primeiro considere escolher um estimador \(a = \widehat{r}_n(x)\) para minimizar as somas de quadrados \(\sum_{i=1}^n (Y_i-a)^2\). A solução é a função constante \(\widehat{r}_n(x)=\overline{Y}\) que obviamente não é um bom estimador de \(r(x)\). Agora defina a função de peso \(w_i(x)=K\big((x_i-x)/h\big)\) e escolha um \(a = \widehat{r}_n(x)\) para minimizar as somas de quadrados ponderadas \begin{equation} \sum_{i=1}^n w_i(x)\big(Y_i-a\big)^2\cdot \end{equation} Do cálculo, vemos que a solução é \begin{equation} \widehat{r}_n(x) \, = \, \frac{\displaystyle\sum_{i=1}^n w_i(x)Y_i}{\displaystyle\sum_{i=1}^n w_i(x)}, \end{equation} que é exatamente o estimador de regressão kernel. Isso nos dá uma interpretação interessante do estimador kernel: é um estimador localmente constante, obtido a partir de mínimos quadrados ponderados localmente.

Isso sugere que podemos melhorar o estimador usando um polinômio local de grau \(p\) em vez de uma constante local. Seja \(x\) algum valor fixo no qual queremos estimar \(r(x)\). Para valores \(u\) em uma vizinhança de \(x\), defina o polinômio \begin{equation} P_x(u;a) \, = \, a_0 \, + \, a_1(u-x) \, + \, \frac{a_2}{2!}(u-x)^2 \, + \, \cdots \, + \frac{a_p}{p!}(u-x)^p\cdot \end{equation} Podemos aproximar uma função de regressão suave \(r(u)\) em uma vizinhança do valor alvo \(x\) pelo polinômio: \begin{equation} r(u) \, = \, P_x(u;a)\cdot \end{equation} Estimamos \(a = (a_0,\cdots, a_p)^\top\) escolhendo \(\widehat{a} = (\widehat{a}_0,\cdots,\widehat{a}_p)^\top\) que minimize a soma de quadrados ponderadas localmente \begin{equation} \sum_{i=1}^n w_i(x)\big( Y_i \, - \, P_x(X_i;a)\big)^2\cdot \end{equation} O estimador \(\widehat{a}\) depende do valor alvo \(x\), então escrevemos \(\widehat{a}(x) = (\widehat{a}_0(x),\cdots,\widehat{a}_p(x))^\top\) se quisermos tornar essa dependência explícita. A estimativa local de \(r\) é \begin{equation} \widehat{r}_n(x) \, = \, P_x(u;\widehat{a})\cdot \end{equation} Em particular, no valor alvo \(u = x\) temos \begin{equation} \widehat{r}_n(x) \, = \, P_x(x;\widehat{a}) \, = \, \widehat{a}_0(x)\cdot \end{equation} Embora \(\widehat{r}_n(x)\) dependa apenas de \(\widehat{a}_0(x)\), isso não é equivalente a simplesmente ajustar uma constante local.

Por exemplo, caso \(p=0\) retornamos ao estimador kernel. O caso especial em que \(p=1\) é chamado de regressão linear local e esta é a versão que recomendamos como uma opção padrão. Como veremos, estimadores polinomiais locais e, em particular, estimadores lineares locais possuem algumas propriedades notáveis como mostrado por Fan (1992) e Hastie e Loader (1993). Muitos dos resultados que se seguem são desses documentos.

Para encontrar \(\widehat{a}(x)\), é útil re-expressar o problema em notação vetorial. Definamos \begin{equation} X_x \, = \, \begin{pmatrix} 1 & (x_1-x) & \cdots & \frac{(x_1-x)^p}{p!} \\ 1 & (x_2-x) & \cdots & \frac{(x_2-x)^p}{p!} \\ \vdots & \vdots & \ddots & \vdots \\ 1 & (x_n-x) & \cdots & \frac{(x_n-x)^p}{p!} \end{pmatrix} \end{equation} e seja \(W_x\) a matriz diagonal \(n\times n\) cujo componente \((i, i)\) é \(w_i(x)\). Podemos então reescrever a soma de quadrados ponderadas localmente como \begin{equation} (Y-X_xa)^\top W_x(Y-X_xa)\cdot \end{equation} Minimizando esta expressão fornece-nos o estimador de mínimos quadrados ponderados \begin{equation} \widehat{a}(x) \, = \, (X_x^\top W_xX_x)^{-1}X_xW_xY\cdot \end{equation} Em particular, \(\widehat{r}_n(x) =\widehat{a}_0(x)\) é o produto interno da primeira linha de \((X_x^\top W_xX_x)^{-1}X_xW_xY\) com \(Y\). Assim nós temos o seguinte teorema.

Mais uma vez, nossa estimativa é linear e podemos escolher a largura de banda por validação cruzada.

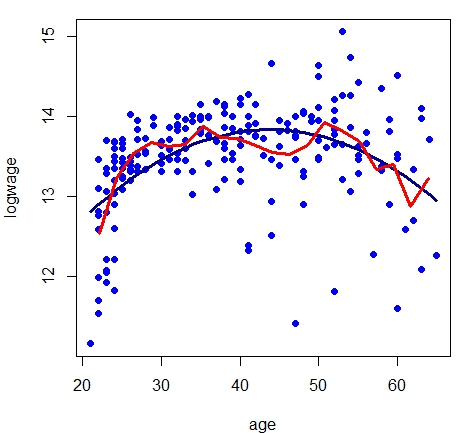

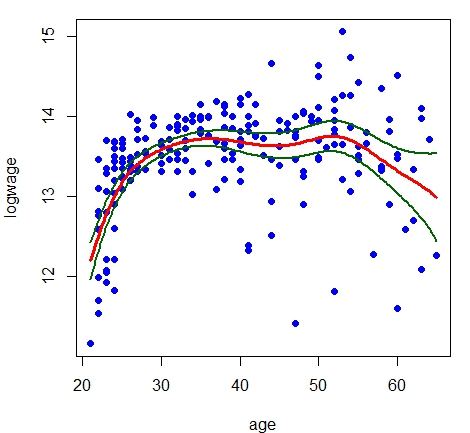

Os dois primeiros gráficos são baseados em pequenas larguras de banda: a esquerda \(h=0.5\) e a direita \(h=1.0\), para isto utilizamos a opção \(bw\) no comando locpol (Local Polynomial estimation.) no pacote de funções homônimo.

|

|

|---|

|

|

|---|

Nos últimos gráficos o da esquerda é baseado numa grande largura de banda \(h=5.0\) e o ajuste é muito suave. O gráfico do canto direito está correto, é aquele onde a largura de banda foi escolhida por validação cruzada. A função para obtermos \(\widehat{h}\) é regCVBwSelC. Foi utilizada para mostrar o procedimento mas não é necessário em situações práticas, é padrão, bastando não dizer nada como em model.npar04. O gráfico esquerdo também mostra a presença de viés perto dos limites. Como veremos, esta é uma característica geral da regressão kernel.

O teorema a seguir apresenta o comportamento amostral em amostras grandes do risco do estimador linear local e mostra por que a regressão linear local é melhor que a regressão kernel.

Assim, o estimador linear local é livre de viés de projeto, é livre de \(f\). Nos pontos de fronteira \(a\) e \(b\), o estimador kernel de Nadaraya-Watson tem um viés assintótico de ordem \(h_n\), enquanto o estimador linear local tem viés de ordem \(h_n^2\). Nesse sentido, a estimativa linear local elimina o viés nos limites.

Sabemos que o procedimento mais adequado, dentre os vistos até agora, é o de polinômios locais. Dediquemos atenção agora a um detalhe na escolha do parâmetro de alisamento \(h\) por validação cruzada. Dizemos que dentre os gráficos mostrados no Exemplo IV.5, o último deles a direita é o correto e isso foi afirmado pelo fato de utilizarmos a validação cruzada para encontrarmos a estimativa do parâmetro de alisamento. Mas, não é bem assim, a seleção por validação cruzada é um pouco mais complexa, como veremos no próximo exemplo.

|

|

|---|

O gráfico à esquerda dedica-se a pesquisar a relação entre o intervalo onde procurar a largura de banda e o valor da estimativa desta, ou seja, a estimativa de \(h\). Para isso definimos dois vetores do mesmo comprimento, sup e hn. No primeiro deles indicaremos o extremo supererior dos intervalos onde procuraremos a estimativa da largura de banda, no segundo guardamos a estimativa da largura de banda obtida.

Mostramos os valores escolhidos para os extremos dos intervalos e as estimativas de \(h\) encontradas.

Os comandos a seguir permitem-nos obter o gráfico acima a esquerda.

Podemos perceber que, caso não especifiquemos o intervalo de busca, podemos obter uma estimativa de \(h\) que não seja a correta. Conforme ampliamos o intervalo desta busca percebemos que os primeiros dois valores estimados correspondem ao limite superior, sendo isto um indicativo que devemos modificar o extremo superior do intervalo de busca. Uma vez feito, encontramos o valor de \(\widehat{h}\) correto, ou seja, não importa quão mais amplo seja o intervalo de busca que a estimativa encontrada não muda. Encontramos então o polinômio local mais adequado à nossos dados.

Resolvemos o primeiro problema, como termos certeza de que o valor obtido de \(\widehat{h}\) seja o correto. Queremos agora encontrar o valor do \(R^2\) nesta situação. Aconte que, por padrão, o comando locpol somente avalia em xevalLen = 100, ou seja, avalia em no máximo 100 pontos a curva estimada. Isto caso sejam mais do que 100 os valores da variável regressora.

Em nosso exemplo temos um total de

A função R2 foi criada por nás e tem por entrada os valores de resposta \(Y\) e de estimativas \(\widehat{r}\). Por resultado temos que \(R^2=0.26\) é o valor do coeficiente de determinação para a regressão polinomial local, valor ligeiramente superior àquele obtido com o modelo de regressão lineal.

Considere mais uma vez o modelo de regressão \begin{equation} Y_i \, = \, r(x_i) \, + \epsilon_i \end{equation} e suponha que estimamos \(r\) escolhendo \(\widehat{r}_n(x)\) que minimiza as somas de quadrados \begin{equation} \sum_{i=1}^n \big( Y_i - \widehat{r}_n(x_i)\big)^2\cdot \end{equation}

A minimização de todas as funções lineares, isto é, das funções da forma \(\beta_0 + \beta_1 x\) produz o estimador de mínimos quadrados. Minimizar todas as funções produz uma função que interpola os dados. Anteriormente evitamos essas duas soluções extremas, substituindo as somas de quadrados por somas de quadrados ponderadas localmente. Uma maneira alternativa de obter soluções entre esses extremos é minimizar as somas de quadrados penalizadas \begin{equation} M(\lambda) \, = \, \sum_{i=1}^n \big( Y_i - \widehat{r}_n(x_i)\big)^2 \, + \, \lambda J(r), \end{equation} onde \(J(r)\) é uma penalidade de aspereza. Adicionar um termo de penalidade ao critério que estamos otimizando é às vezes chamado de regularização.

Vamos nos concentrar no caso especial \begin{equation} J(r) \, = \, \int \big(r''(x) \big)^2\mbox{d}x\cdot \end{equation} O parâmetro \(\lambda\) controla a troca entre o ajuste e a penalidade. Vamos denotar por \(\widehat{r}_n\) a função que minimiza \(M(\lambda)\). Quando \(\lambda = 0\), a solução é a função de interpolação. Quando \(\lambda \to \infty \), \(\widehat{r}_n\) converge para a linha de mínimos quadrados. O parâmetro \(\lambda\) controla a quantidade de suavização. Como é a aparência do \(\widehat{r}_n\) para \(0 <\lambda <\infty\)? Para responder a essa pergunta, precisamos definir splines.

Spline é um polinômio especial por partes, mais detalhes sobre splines podem ser encontrados em Wahba (1990). Os splines mais utilizadas são splines cúbicos por partes.

Splines cúbicos, ou seja, com \(m = 4\) são os splines mais comuns usados na prática. Eles surgem naturalmente na estrutura de regressão penalizada, como mostra o seguinte teorema.

O teorema acima não fornece uma forma explícita para \(\widehat{r}_n\). Para fazer isso, vamos construir uma base para o conjunto de splines.

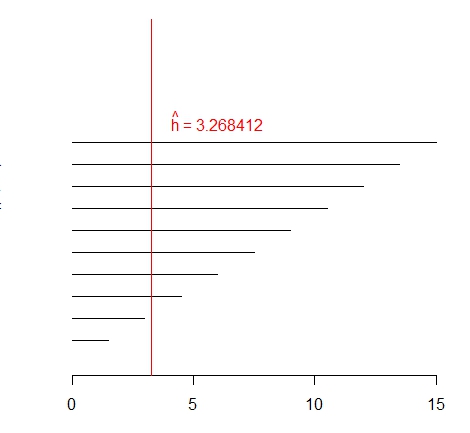

Agora, introduzimos uma base diferente para o conjunto de splines naturais, chamada de base B-spline, que é particularmente adequada para computação. Estes são definidos da seguinte maneira.

Seja \(\xi_0=a\) e \(\xi_{k+1}=b\). Definimos novos nós \(\tau_1,\cdots,\tau_m\) tais que \begin{equation} \tau_1 \leq \tau_2 \leq \tau_3 \leq \cdots \leq \tau_m \leq \xi_0, \end{equation} \(\tau_{j+m}=\xi_j\) para \(j=1,\cdots,k\) e \begin{equation} \xi_{k+1} \leq \tau_{k+m+1} \leq \cdots \leq \tau_{k+2m}\cdot \end{equation}

A escolha dos nós extras é arbitrária; geralmente escolhemos \(\tau_1=\cdots=\tau_m=\xi_0\) e \(\xi_{k+1}=\tau_{k+m+1}=\cdots=\tau_{k+2m}\). Definimos as funções na base recursivamente do seguinte modo. Primeiro definimos \begin{equation} B_{i,1}(x)=\left\{ \begin{array}{cc} 1, & \mbox{ caso } \tau_i\leq x < \tau_{i+1} \\ 0, & \mbox{ caso contrário}\end{array}\right., \end{equation} para \(i=1,2,\cdots,k+2m-1\). Em seguida, para \(r \leq m\) definimos \begin{equation} B_{i,r}(x) \, = \, \displaystyle \frac{x-\tau_i}{\tau_{i+r-1}-\tau_i}B_{i,r-1}(x) \, + \, \frac{\tau_{i+r}-x}{\tau_{i+r}-\tau_{i+1}}B_{i+1,r-1}(x), \end{equation} para \(i = 1,\cdots,k + 2m−r\). Entende-se que, se o denominador é 0, a função é definida como 0.

Base cúbica B-spline usando nove nós igualmente espaçados em (0,1).

Base cúbica B-spline usando nove nós igualmente espaçados em (0,1). |

|---|

O gráfico acima foi obtido pelos comandos a seguir.

Por padrão, os splines são cúbicos, ou seja, com \(m=4\) ou \(degree = 3\) não sendo necessário especificar.

A vantagem das funções de base B-spline é que elas possuem suporte compacto que torna possível acelerar os cálculos. Veja Hastie et al. (2001) para detalhes. A figura acima mostra a base cúbica B-spline usando nove nós igualmente espaçados em (0,1).

Estamos agora em condições de descrever o estimador spline em mais detalhes. De acordo com o Teorema IV.6, \(\widehat{r}\) é um spline cúbico natural. Portanto, podemos escrever \begin{equation} \widehat{r}_n(x) \, = \, \sum_{i=1}^N \widehat{\beta}_j B_j(x), \end{equation} onde \(B_1,\cdots,B_N\) são uma base para os splines naturais, como os B-splines com \(N = n + 4\). Assim, precisamos apenas encontrar os coeficientes \(\widehat{\beta}=(\widehat{\beta}_1,\cdots,\widehat{\beta}_N)^\top\). Ao expandir \(r\) na base, podemos agora reescrever a minimização da seguinte forma: \begin{equation} \mbox{minimizar: } \qquad (Y-B\beta)^\top (Y-B\beta) \, + \, \lambda \beta^\top \Omega \beta, \end{equation} onde \(B_{i,j}=B_j(X_i)\) e \(\Omega_{jk}=\int B_j''(x)B_k''(x)\mbox{d}x\).

Deste teorema concluímos que os splines são outro exemplo de suavizadores lineares.

Se tivéssemos feito uma regressão linear ordinária de \(Y\) em \(B\), a matriz chapéu seria \(L = B(B^\top B)^{-1}B^\top\) e os valores ajustados interpolariam os dados observados. O efeito do termo \(\lambda\Omega\) é reduzir os coeficientes de regressão para um subespaço, o que resulta em um ajuste mais suave. Como antes, nós definimos os graus de liberdade efetivos por \(\nu = \mbox{tr}(L)\) e escolhemos o parâmetro de suavização \(\lambda\) por validação cruzada.

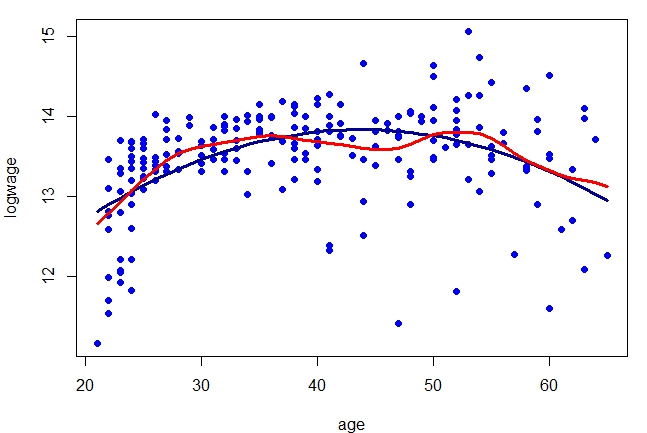

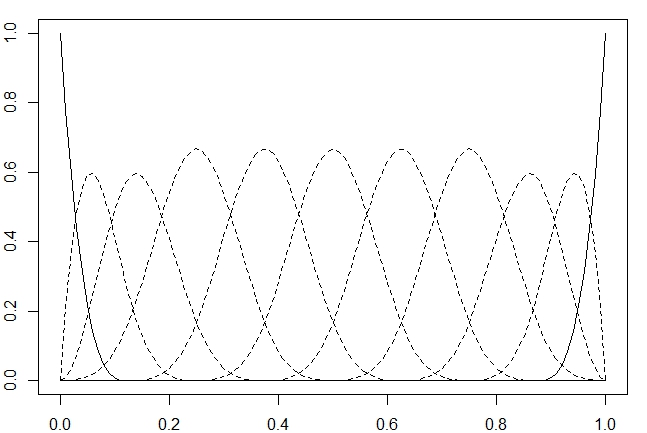

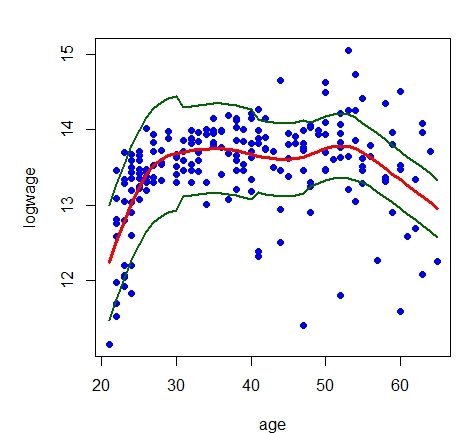

|

|---|

A figura mostra o spline de suavização obtido por validação cruzada para os dados em cps71. O número efetivo de graus de liberdade é 7.8. O ajuste é tão suave quanto o obtido com o estimador de regressão local. A diferença entre os dois ajustes é pequena comparada com a largura das bandas de confiança que iremos calcular mais tarde.

Para podermos clacular o valor do \(R^2\) nesta situação procedemos como mostrado a seguir.

Observa-se que o valor do \(R^2=0.33\) é muito maior do que o obtido por outros modelos apresentados.

Consideramos vários métodos para estimar \(\sigma^2\). Para suavizadores lineares, existe uma estimativa simples e quase isenta de \(\sigma^2\).

Aqui mostramos um outro estimador, devido a Rice (1984). Suponha que os \(x_i\) estejam ordenados. Definimos \begin{equation} \widehat{\sigma}^2 \, = \, \frac{1}{2(n-1)}\sum_{i=1}^{n-1} \big( Y_{i+1}-Y_i\big)^2\cdot \end{equation} A motivação para este estimador é a seguinte. Assumindo que \(r(x)\) é suave, temos que \(r(x_{i+1})-r(x_i)\approx 0\) e portanto \begin{equation} Y_{i+1}-Y_i \, = \, \big( r(x_{i+1})+\epsilon_{i+1}\big) \, - \, \Big(r(x_i)+\epsilon_i\Big) \, \approx \, \epsilon_{i+1}-\epsilon_i \end{equation} e, portanto \(\big( Y_{i+1}-Y_i\big)^2\approx \epsilon_{i+1}^2+\epsilon_i^2-2\epsilon_{i+1}\epsilon_i\). Assim sendo, \begin{equation} \begin{array}{rcl} \mbox{E}\big( Y_{i+1}-Y_i\big)^2 & \approx & \mbox{E}(\epsilon_{i+1}^2) \, + \, \mbox{E}(\epsilon_i^2) \, - \, 2\mbox{E}(\epsilon_{i+1})\mbox{E}(\epsilon_i) \\ & = & \mbox{E}(\epsilon_{i+1}^2) \, + \, \mbox{E}(\epsilon_i^2) \, = \, 2\sigma^2\cdot \end{array} \end{equation} Assim, \(\mbox{E}(\widehat{\sigma}^2)\approx \sigma^2\). Uma variação deste estimador, devido a Gasser et al. (1986) é \begin{equation} \widehat{\sigma}^2 = \frac{1}{n-2}\sum_{i=2}^{n-1} c_i^2\delta_i^2, \end{equation} onde \begin{equation} \begin{array}{ll} \delta_i \, = \, a_iY_{i-1} \, + \, b_iY_{i+1} \, - \, Y_i, & a_i \, = \, (x_{i+1}-x_i)/(x_{i+1}-x_{i-1}), \\ b_i \, = \, (x_{i}-x_{i-1})/(x_{i+1}-x_{i-1}), & c_i^2 \, = \, (a_i^2 \, + \, b_i^2 \, + \, 1)^{-1}\cdot \end{array} \end{equation} A intuição deste estimador é que é a média dos resíduos que resultam da montagem de uma linha ao primeiro e terceiro ponto de cada triplo consecutivo de pontos.

Até agora assumimos a homocedasticidade, significando que \(\sigma^2= \mbox{Var}(\epsilon_i)\) não varia com \(x\). No Exemplo IV.1 isso é flagrantemente falso. Claramente, \(\sigma^2\) aumenta com \(x\), então os dados são heterocedásticos. A estimativa da função \(\widehat{r}_n(x)\) é relativamente insensível à heterocedasticidade. No entanto, quando se trata de fazer bandas de confiança para \(r(x)\), devemos levar em conta a variância não constante.

Vamos assumir a seguinte abordagem. Veja Yu and Jones (2004) e referências para outras abordagens. Suponha que \begin{equation} Y_i \, = \, r(x_i) \, + \, \sigma(x_i)\epsilon_i\cdot \end{equation} Seja \(Z_i \, = \, \mbox{log}\big(Y_i-r(x_i)\big)^2\) e \(\delta_i \, = \, \mbox{log}(\epsilon_i^2)\). Então, \begin{equation} Z_i \, = \, \mbox{log}\big(\sigma^2(x_i)\big) \, + \, \delta_i\cdot \end{equation} Isto sugere obter a estimativa de \(\mbox{log}\big(\sigma^2(x)\big)\) pela regressão do logaritmo dos resíduos ao quadrado em \(x\).

Prosseguimos como segue:Uma desvantagem dessa abordagem é que o logaritmo de um resíduo muito pequeno será um grande outlier. Uma alternativa é suavizar diretamente os resíduos quadrados.

|

|

|---|

Em ambos gráficos mantivemos a mesma escala nos eixos, isto com o objetivo de melhor visualizar as diferenças entre as curvas e entre os pontos, que são o logaritmo dos resíduos ao quadrado. Percebemos que tanto os resíduos quanto as curvas são bem diferentes entre estes modelos.

Com as linhas acima fizemos os gráficos mostrados e ainda obtivemos a variância de cada modelo armazenadas nos objetos sigma05 e sigma06, respectivamente.

Nesta seção, vamos construir faixas de confiança para \(r(x)\). Normalmente, essas bandas são da forma \begin{equation} \widehat{r}_n(x) \, \pm \, c \, \mbox{se}(x), \end{equation} onde \(\mbox{se}(x)\) é uma estimativa do desvio padrão de \(\widehat{r}_n(x)\) e \(c> 0\) é alguma constante. Antes de prosseguirmos, discutimos um problema pernicioso que surge sempre que fazemos o alisamento, ou seja, o problema do viés.

Denote a média e o desvio padrão de \(\widehat{r}_n(x)\) por \(\overline{r}_n(x)\) e \(s_n(x)\). Então, \begin{equation} \begin{array}{rcl} \displaystyle\frac{\widehat{r}_n(x)-r(x)}{s_n(x)} & = & \displaystyle\frac{\widehat{r}_n(x)-\overline{r}_n(x)}{s_n(x)} \, + \, \frac{\overline{r}_n(x)-r(x)}{s_n(x)} \\ & = & Z_n(x) \, + \, \, + \, \displaystyle\frac{\mbox{bias}\big( \widehat{r}_n(x)\big)} {\sqrt{\mbox{variância}\big( \widehat{r}_n(x)\big)}}, \end{array} \end{equation} onde \(Z_n(x)=\big(\widehat{r}_n(x)-\overline{r}_n(x)\big)/s_n(x)\). Tipicamente, o primeiro termo \(Z_n(x)\) converge para uma Normal padrão do qual derivam as faixas de confiança. O segundo termo é o viés dividido pelo desvio padrão. Na inferência paramétrica, o viés é geralmente menor que o desvio padrão do estimador, portanto, esse termo vai para zero à medida que o tamanho da amostra aumenta. Na inferência não paramétrica, vimos que o alisamento ótimo corresponde ao balanceamento do viés e do desvio padrão. O segundo termo não desaparece mesmo com amostras grandes.

A presença desse segundo termo não invasivo introduz um viés no limite Normal. O resultado é que o intervalo de confiança não será centrado em torno da verdadeira função \(r\) devido ao viés de suavização \(\overline{r}_n(x)-r(x)\).

Existem várias coisas que podemos fazer sobre esse problema. A primeira é: viva com isso. Em outras palavras, basta aceitar o fato de que a faixa de confiança é para \(\overline{r}_n(x)\) não para \(r\). Não há nada de errado com isso, contanto que tenhamos cuidado quando reportarmos os resultados para deixar claro que as inferências são para \(\overline{r}_n\) não \(r\). Uma segunda abordagem é estimar a função de viés \(\overline{r}_n(x) - r(x)\). Isso é difícil de fazer. De fato, o termo principal do viés é \(r''(x)\) e a estimativa da segunda derivada de \(r\) é muito mais difícil do que a estimativa de \(r\). Isso requer a introdução de condições de suavidade extras que, em seguida, colocam em questão o estimador original que não usou essa suavidade extra. Isso tem uma certa circularidade desagradável para ele. Uma terceira abordagem é a falta de bom senso. Se suavizarmos menos do que a quantidade ideal, a tendência diminuirá assintoticamente em relação à variação. Infelizmente, não parece haver uma regra prática simples para escolher a quantidade certa de sub alisamento.Adotaremos a primeira abordagem e nos contentaremos em encontrar uma banda de confiança para \(\overline{r}_n(x)\).

Por enquanto, vamos assumir que \(\sigma^2(x)=\sigma^2=\mbox{Var}(\epsilon_i)\) seja constante. Então, \begin{equation} \mbox{Var}\big(\widehat{r}_n(x)\big) \, = \, \sigma^2 ||\mathcal{l}(x) ||^2\cdot \end{equation}

Vamos considerar uma banda de confiança para \(\overline{r}_n(x)\) da forma \begin{equation} \mbox{I}(x) \, = \, \Big( \widehat{r}_n(x) \, - \, c \widehat{\sigma}||\mathcal{l} ||, \, \widehat{r}_n(x) \, + \, c \widehat{\sigma}||\mathcal{l} ||\Big), \end{equation} para algum \(c>0\) e \(a\leq x\leq b\).

Seguiremos a abordagem em Sun and Loader (1994). Primeiro suponha que \(\sigma\) é conhecido. Então, \begin{equation} P\Big( \overline{r}(x) \, \notin \, \mbox{I}(x) \; \mbox{para algum} \; x\in[a,b]\Big) \, = \, \displaystyle P\left( {\mbox{max}_{x\in [a,b]}} \, \frac{|\widehat{r}_n(x)-\overline{r}_n(x)|}{\sigma||\mathcal{l} ||} > c \right) \, = \\ \qquad \qquad \qquad \qquad \qquad \qquad = \, P\left( {\mbox{max}_{x\in [a,b]}} \, \frac{|\sum_{i=1}^n \epsilon_i\mathcal{l}_i(x)|}{\sigma||\mathcal{l} ||} > c \right) \, = \, P\left( {\mbox{max}_{x\in [a,b]}} \, |W(x)| > c \right), \end{equation} onde \(W(x)=\sum_{i=1}^n Z_i T_i(x)\), \(Z_i=\epsilon_i/\sigma\sim N(0,1)\) e \(T_i(x)=\mathcal{l}_i(x)/||\mathcal{l}(x)||\). Agora, \(W(x)\) é um processo gaussiano. Para encontrar \(c\), precisamos ser capazes de calcular a distribuição do máximo de um processo gaussiano. Felizmente, esse é um problema bem estudado. Em particular, Sun and Loader (1994) mostraram que, a chamada de fórmula tubo, é dada por \begin{equation} P\left( \max_x \Big| \sum_{i=1}^n Z_i T_i(x)\Big|> c \right) \, \approx \, 2\big( 1-\Phi(c)\big) \, + \, \frac{\kappa_0}{\pi}e^{-c^2/2}, \end{equation} para \(c\) grande, onde \begin{equation} \kappa_0 \, = \, \int_a^b || \, T'(x) \, ||\mbox{d}x, \end{equation} \(T'(x)=(T_1'(x),\cdots,T_n'(x))\) e \(T_i'(x)=\partial T_i(x)/\partial x\). Se escolhermos \(c\) como o valor que resolve a equação \begin{equation} 2\big( 1-\Phi(c)\big) \, + \, \frac{\kappa_0}{\pi}e^{-c^2/2} \, = \, \alpha, \end{equation} então obtemos a banda de confiança simultánea desejada. Caso \(\sigma\) seja desconhecido, usamos uma estimativa \(\widehat{\sigma}\). Sun and Loader sugerem substituir o lado direito da fórmula tubo com \begin{equation} P(|T_m|>c) \, + \, \frac{\kappa_0}{\pi}\left( 1+\frac{c^2}{m}\right)^{-m/2} \end{equation} onde \(T_m\) têm distribuição \(t-Student\) com \(m=n-\mbox{tr}(L)\) graus de liberdade. Para \(n\) grande, continua a ser uma aproximação adequada.

Agora suponhamos que \(\sigma(x)\) seja uma função de \(x\). Então, \begin{equation} \mbox{Var}\big( \widehat{r}_n(x)\big) \, = \, \sum_{i=1}^n \sigma^2(x_i)l_i^2(x)\cdot \end{equation} Neste caso escolhemos que \begin{equation} I(x) \, = \, \widehat{r}_n(x)\pm c \, s(x), \end{equation} sendo que \begin{equation} s(x) \, = \, \sqrt{\sum_{i=1}^n \widehat{\sigma}^2(x_i)l_i^2(x)}, \end{equation} onde \(\widehat{\sigma}(x)\) é um estimador de \(\sigma(x)\) e \(c\) é a constante definida acima. Caso \(\widehat{\sigma}(x)\) varie lentamente com \(x\), então \(\sigma_(x_i)\approx \sigma(x)\) para aqueles \(i\) tais que \(l_i(x)\) é grande e então \begin{equation} s(x) \, \approx \, \widehat{\sigma}(x)||l(x)||\cdot \end{equation}

Assim, uma banda de confiança aproximada é \begin{equation} I(x) \, = \, \widehat{r}_n(x) \, \pm \, c \, \widehat{\sigma}(x)||l(x)||\cdot \end{equation} Para mais detalhes sobre esses métodos, veja Faraway and Sun (1995). Esta será a banda de confiança que utilizaremos de preferência.

|

|

|---|

Tratamos assim os pontos no gráfico de dispersão como uma população completa e, em seguida, extraímos uma amostra deles, com substituição, tão grande quanto o original. Também precisamos de um estimador. O que queremos fazer é obter um monte de curvas de spline, uma em cada conjunto de dados simulado. Mas, como os valores da variável de entrada mudam de uma simulação para outra, para tornar tudo comparável, avaliamos cada função spline em uma grade fixa de pontos, que percorre o intervalo dos dados.

Isso define o número de pontos de avaliação como 300, que é grande o suficiente para dar curvas visualmente suaves, mas não tão grandes a ponto de serem computacionalmente incômodas. Agora juntemo-os para obter bandas de confiança.

O valor de retorno aqui é uma lista que inclui a curva ajustada original, os limites de confiança inferior e superior e os pontos nos quais todas as funções foram avaliadas.

Construímos a nova base de dados dados porque nas funções spline.estimaotr e spline.cis assumimos a primeira coluna como x e a segunda coluna da base dados como y. Observe que na base de dados original estas variáveis estavam trocadas de posição.

|

|

|---|

Na Figura acima mostramos dois gráficos, à esquerda os limites de confiança de 95% resultantes, com base nas B = 1000 replicações bootstrap. Estas bandas são claramente assimétricos da mesma forma que a curva se ajusta a todos os dados, mas perceba como eles são largas e como eles se ampliam à medida que vamos do centro dos dados em qualquer direção. No caso do gráfico à direita utilizamos o resultado das bandas de confiança mostradas nesta seção e utilizamos o resultado guardado em sigma06, para isso utilizamos os comandos listados abaixo.

Pode-se argumentar que exigir que as bandas de confiança cubram a função em todos os \(x\) é muito rigoroso. Wahba (1983), Nychka (1988) e Cummins et al. (2001) introduziram um tipo diferente de cobertura a que nos referimos como cobertura média. Aqui vamos discutir um método para construir bandas de cobertura média com base na ideia em Juditsky e Lambert-Lacroix (2003).

Suponha que estamos estimando \(r(x)\) no intervalo \([0,1]\). Defina a cobertura média de uma banda \((\mathcal{l}, u)\) por \begin{equation} \mathcal{C} \, = \, \int_0^1 P\big( r(x) \in [\mathcal{l}(x),u(x)]\big)\mbox{d}x\cdot \end{equation} Vamos construir bolas de confiança para \(r\), os quais são conjuntos \(\mathcal{B}_n(\alpha)\), da forma \begin{equation} \mathcal{B}_n(\alpha) \, = \, \big\{ r \, : \, ||\widehat{r}_n \, - \, r || \, \leq \, s_n(\alpha)\big\}, \end{equation} tais que \begin{equation} P\big( r \, \in \, \mathcal{B}_n(\alpha)\big) \, \geq \, 1-\alpha\cdot \end{equation}

Dada uma bola de confiança, sejam \begin{equation} \displaystyle \mathcal{l}(x) \, = \, \widehat{r}_n(x) \, - \, s_n(\alpha/2)\sqrt{\frac{2}{\alpha}}, \qquad \displaystyle u(x) \, = \, \widehat{r}_n(x) \, + \, s_n(\alpha/2)\sqrt{\frac{2}{\alpha}}\cdot \end{equation}

Nós agora vamos mostrar que essas bandas têm uma cobertura média de pelo menos \(1 - \alpha\). Primeiro, observe que \(\mathcal{C} = P\big(r(U)\in [\mathcal{l}(U), u(U)]\big)\) onde \(U\sim U(0,1)\) é independente dos dados. Seja \(A\) o evento que \(r \in \mathcal{B}_n(\alpha/2)\). No evento \(A\), \(||\widehat{r}_n \, - \, r || \, \leq \, s_n(\alpha)\). Escrevendo \(s_n\) para \(s_n(\alpha/2)\) temos, \begin{equation} \begin{array}{rcl} 1 - \mathcal{C} & = & P\Big( r(U) \, \notin [\mathcal{l}(U), u(U))]\Big) \, = \, P\Big( |\widehat{r}_n(U) - r(U)| \, > \, s_n\sqrt{\frac{2}{\alpha}}\Big) \\ & = & P\Big( |\widehat{r}_n(U) - r(U)| \, > \, s_n\sqrt{\frac{2}{\alpha}}, \, A \Big) \, + \, P\Big( |\widehat{r}_n(U) - r(U)| \, > \, s_n\sqrt{\frac{2}{\alpha}}, \, A^c \Big) \\ & \leq & P\Big( |\widehat{r}_n(U) - r(U)| \, > \, s_n\sqrt{\frac{2}{\alpha}}, \, A \Big) \, + \, P(A^c) \\ & \leq & \displaystyle\frac{\mbox{E}\big( \mbox{I}_A||\widehat{r}_n \, - \, r ||^2 \big)}{\displaystyle s_n^2\frac{2}{\alpha}} \, + \, \frac{\alpha}{2} \, \leq \, \frac{s_n^2}{\displaystyle s_n^2\frac{2}{\alpha}} \, + \, \frac{\alpha}{2} \, \leq \, \alpha\cdot \end{array} \end{equation}

Suponhamos agora que a covariável seja de dimensão \(d\), ou seja, \begin{equation} x_i \, = \, (x_{i1},x_{i2},\cdots,x_{id} )^\top\cdot \end{equation} O modelo de regressão assume a forma \begin{equation} Y \, = \, r(x_{1},x_{2},\cdots,x_{d} ) \, + \, \epsilon\cdot \end{equation}

Em princípio, todos os métodos que discutimos passam facilmente para este caso. Infelizmente, o risco de um estimador de regressão não paramétrico aumenta rapidamente com a dimensão \(d\). Em um problema unidimensional, a taxa ótima de convergência de um estimador não paramétrico é \(n^{−4/5}\) se \(r\) é assumido como tendo uma segunda derivada integrável. Em \(d\) dimensões, a taxa ótima de convergência é \(n^{−4/(4 + d)}\). Assim, o tamanho da amostra \(m\) requerido para um problema \(d\)-dimensional ter a mesma precisão que um tamanho de amostra \(n\) em um problema unidimensional é \(m \propto n^{cd}\) onde \(c = (4 + d) / (5d)> 0\). Isto implica que para manter um determinado grau de precisão de um estimador, o tamanho da amostra deve aumentar exponencialmente com a dimensão \(d\). Em outras palavras, as bandas de confiança ficam muito grandes à medida que a dimensão \(d\) aumenta. No entanto, vamos continuar e ver como podemos estimar a função de regressão.

Considere a regressão linear local. A função kernel \(K\) é agora uma função de \(d\) variáveis. Dada uma matriz \(d \times d\) de largura de banda definida positiva não-singular \(H\), definimos \begin{equation} K_H \, = \, \frac{1}{|H|^{1/2}}K\big( H^{1/2}x\big)\cdot \end{equation} Muitas vezes, a escala de cada covariada tem a mesma média e variância e então usamos o kernel \begin{equation} h^{-k}K\big(||x||/h \big), \end{equation} onde \(K\) é qualquer kernel unidimensional. Então há um único parâmetro de largura de banda \(h\). Num valor alvo \(x = (x_1,\cdots, x_d)^\top\) a soma dos quadrados local é dada por \begin{equation} \sum_{i=1}^n \omega_i(x)\Big( Y_i \, - \, a_0 \sum_{j=1}^d a_j (x_{ij}-x_j)\Big)^2 \end{equation} onde \begin{equation} \omega_i(x) \, = \, K(||x_i-x||/h)\cdot \end{equation} O estimador é \begin{equation} \widehat{r}_n(x) \, = \, \widehat{a}_0, \end{equation} onde \(\widehat{a}=(\widehat{a}_0,\cdots,\widehat{a}_d)^\top\) é o valor de \(a=(a_0,\cdots,a_d)^\top\) que minimiza a soma de quadrados ponderada. A solução \(\widehat{a}\) é \begin{equation} \widehat{a} \, = \, (X_x^\top W_xX_x)^{-1}X_x^\top W_xY \end{equation} onde \begin{equation} X_x \, = \, \begin{pmatrix} 1 & x_{11}-x_1 & \cdots & x_{1d}-x_d \\ 1 & x_{21}-x_1 & \cdots & x_{2d}-x_d \\ \vdots & \vdots & \ddots & \vdots \\ 1 & x_{n1}-x_1 & \cdots & x_{nd}-x_d \end{pmatrix} \end{equation} e \(W_x\) é a matriz diagonal cujo elemento \((i, i)\) é \(w_i(x)\).

As propriedades teóricas da regressão polinomial local em dimensões maiores são discutidas no seguinte teorema.

Ao estudarmos a regressão local conhecemos duas formas de avaliarmos estes estimadores: o estimador kernel Nadaraya–Watson e os polinômios locais. No Teorema IV.5 mostramos que a regressão linear local é melhor que a regressão kernel. Acontece que, pelo menos até o nosso conhecimento, os procedimentos implementados no R somente permitem a estimação do modelo de regressão por polinômios locais até ordem 2, ou seja, somente aceitam no máximo duas covariáveis contínuas. Nos referimos especificamente ao pacote de funções locpol. Significa que, para aplicarmos modelos de regressão não paramétrica a situações mais complexas devemos recorrer ao estimador kernel, muito bem implementado no pacote de funções np e descrito no artigo de Hayfield and Racine (2008).

O pacote np implementa uma variedade de estimadores não paramétricos e semiparamétricos baseados no estimador kernel Nadaraya–Watson Existem também procedimentos para testes de significância não paramétricos e testes consistentes de especificação de modelo. Este pacote foca nos métodos apropriados para a combinação de dados contínuos, discretos e categóricos, frequentemente encontrados em problemas aplicados. Os métodos de seleção de largura de banda orientados por dados são enfatizados, embora tenhamos cautela já que estes procedimentos podem ser exigentes em termos computacionais.

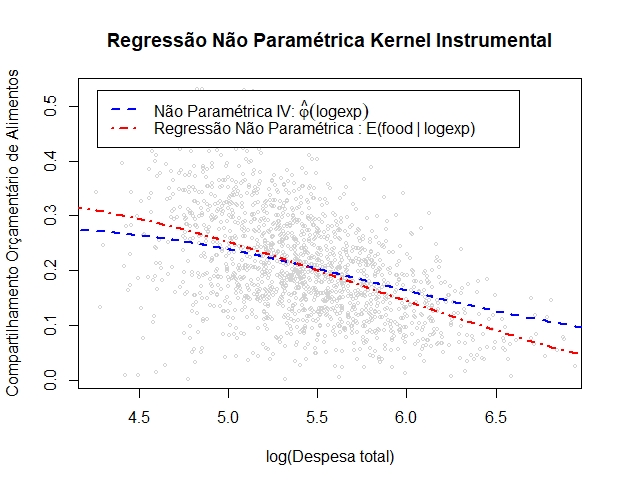

|

|---|

Esta aqui é uma ilustração simples para ajudá-lo a começar com a regressão do Kernel multivariada e a plotagem através da função de plotagem do R que chama npplot, no mesmo pacote np.

Assim, vemos que em dimensões mais altas, a regressão linear local ainda evita excessivo viés de limite e viés de design.

Interpretar e visualizar um ajuste de alta dimensão é difícil. À medida que o número de covariáveis aumenta, a carga computacional torna-se proibitiva. Ás vezes, uma abordagem mais frutífera é usar um modelo aditivo. Um modelo aditivo é um modelo da forma \begin{equation} Y \, = \, \mu \, + \, \sum_{j=1}^d r_j(x_i) \, + \, \epsilon, \end{equation} onde \(r_1,\cdots,r_d\) são funções suaves. Acontece que este modelo não é identificável, pois podemos adicionar qualquer constante a \(\mu\) e subtrair a mesma constante de um dos \(r_j\) sem alterar a funçção de regressão. Este problema pode ser corrigido de várias maneiras, talvez o mais fácil seja definir \(\widehat{\mu}=\overline{Y}\) e, em seguida, considerar os \(r_j\) como desvios de \(\overline{Y}\). Neste caso, exigimos que \begin{equation} \sum_{i=1}^n r_j(x_i) \, = \, 0, \end{equation} para cada \(j\).

O modelo aditivo claramente não é tão geral quanto estimar \(r(x_1,\cdots, x_d)\), mas é muito mais simples de ser computado e interpretado e, portanto, é geralmente um bom ponto de partida. Apresentamos um algoritmo simples para transformar qualquer regressão unidimensional mais suave em um método para ajustar modelos aditivos, chamado de backfitting ou adaptação.

Uma forma de implementar este algoritmo está disponível para modelos de regressão linear múltipla aplicando splines a somente uma covarável, isso não significa que poderemos aplicar splines a somente uma covariálvel por vez. Significa que aplicaremos splines undimensionais a uma ou várias covariáveis isoladamente. Veja no seguinte exemplo a forma de utilizarmos o comando ns dentro do pacote de funções splines..

Os dados em mtcars, disponíveis na base do R, foram extraídos da revista Motor Trend nos Estados Unidos de 1974 e compreendem o consumo de combustível e 10 aspectos do projeto e desempenho de 32 automóveis modelos de 1973 a 1974.

Interéssa-nos como reposta mpg ou milhas/galão em dólares americanos, como covariáveis temos gear ou a engrenagem contando o número de marchas para a frente, a qual é discreta ou um fator; wt o peso em 1000 libras e hp a potência bruta do motor.

Nesta abordagem precisamos definir splines em dimensões maiores. Para \(d = 2\), minimizamos \begin{equation} \sum_i \big( Y_i \, - \, \widehat{r}_n(x_{i1},x_{i2})\big)^2 \, + \, \lambda \, J(r), \end{equation} onde \begin{equation} J(r) \, = \, \int\int\left[ \left(\frac{\partial^2 r(x)}{\partial x_1^2}\right) \, + \, 2\left(\frac{\partial^2 r(x)}{\partial x_1\partial x_2}\right) \, + \, \left(\frac{\partial^2 r(x)}{\partial x_2^2}\right)\right] \mbox{d}x_i\mbox{d}x_2\cdot \end{equation}

O minimizedor \(\widehat{r}_n\) é chamado spline de placa fina. É difícil descrever e ainda mais difícil, mas certamente não impossível, de ajustar. Veja Green and Silverman (1994) para mais detalhes.

Utilizando os mesmos dados, podemos considerar interações entre as variáveis wt e hp, agora do tipo contínuas e aplicados aplines undimensionais a cada uma separadamente.

Ou podemos utilizar o comando s no pacote mgcv com o qual podemos ajutar splines bidimensionais.

Perceba que, desta última forma, tivemos um ganho real no ajuste, o \(R^2\) ajustado é de 0.898. Lembremos que estamos trabalhando com modelos de regressão, com isso a melhor maneirra de descubrirmos se estamos realizaddo um ajuste adequado é analisando os resíduos. Para isso, qualquer seja o modelos escolhido, sempre é possível utilizarmos o comando residuals e mostrar gráficos e testes adequados.

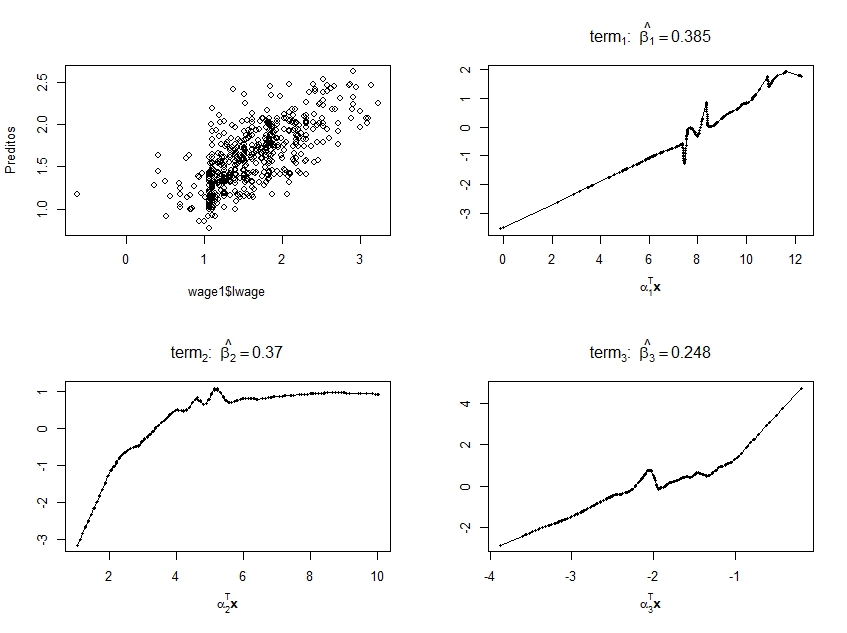

Vamos supor que o vetor de variáveis explicativas \(X = (x_1,\cdots, x_p)\) seja de alta dimensão. O modelo aditivo \begin{equation} Y = \mu + \sum_{j=1}^p f_j(x_j) + \epsilon \end{equation} pode ser muito flexível, pois permite alguns graus de liberdade por cada covariável, mas não cobre o efeito de interações entre as variáveis independentes, explicativas ou covariáveis. A regressão por prospeção de projeção, proposto por Friedman and Stuetzle (1981), aplica um modelo aditivo às variáveis projetadas. A ideia é aproximar a função de regressão \(r(x_1,x_2,\cdots,x_p)\) com uma função da forma \begin{equation} \mu+\sum_{m=1}^M r_m(z_m), \end{equation} onde \begin{equation} z_m \, = \, \alpha_m^\top X \end{equation} e cada \(\alpha_m\) é um vetor unitário, ou seja, de comprimento um, para \(m = 1,\cdots,M\).

Assim, ele usa um modelo aditivo nas variáveis preditoras que são formadas projetando \(X\) em \(M\) direções cuidadosamente escolhidas. Mesmo sendo \(M\) muito grande tais modelos podem aproximar, uniformemente em conjuntos compactos e em muitos outros sentidos, funções contínuas arbitrárias de \(X\). Os termos \(r_m(z_m)\) são chamados de funções de crista, uma vez que são constantes em todas as direções, exceto uma.

Note que cada \(z_m\) é a projeção de \(X\) num subespaço. O vetor de direção \(\alpha\) é escolhido em cada etapa para minimizar a fração de variância inexplicada. Em mais detalhes, denotemos por \(S(\cdot)\) o mapeamento que produz \(n\) valores ajustados de algun método de alisamento, dados os \(Y_i\) e alguns valores das covariáveis unidimensionais \(z_1,\cdots, z_n\). Seja também \(\widehat{μ} = \overline{Y}\) e substitua \(Y_i\) por \(Y_i - \overline{Y}\). Assim, os \(Y_i\) agora têm média 0. Da mesma forma, modificamos as covariáveis para que cada uma tenha a mesma variância. Então siga os seguintes passos:

As informações adicionadas são os vetores de direção \(\alpha_m\) e os coeficientes \(\beta_{im}\) em \begin{equation} Y_i \, = \, \mu_{i} \, + \, \sum_{m=1}^M \beta_{im}r_m(\alpha_m^\top X) \, + \, \epsilon\cdot \end{equation} Note que esta é uma extensão do modelo de regressão por prospeção de projeção para múltiplas respostas e, então, separamos os escalonamentos das funções suaves \(r_m\), que são escalonadas para ter média zero e variância unitária sobre as projeções do conjunto de dados.

O algoritmo primeiro acrescenta os \(M_{max}\) termos (max.terms) um de cada vez; ele usará menos se não conseguir encontrar um termo para adicionar que faça diferença suficiente. Em seguida, ele remove o termo menos importante em cada etapa até que os \(M\) (nterms) termos sejam deixados.