Nesta sessão vamos verificar como utilizar o R para obter intervalos de confiança e testar hipóteses sobre parâmetros de interesse.

Considere resolver o seguinte problema:

Exemplo 1

O tempo de reação de um novo medicamento pode ser considerado como tendo distribuição

Normal e deseja-se fazer inferência sobre a média que é desconhecida obtendo um intervalo de

confiança. Vinte pacientes foram sorteados e tiveram seu tempo de reação anotado. Os dados foram

os seguintes (em minutos):

| 2.9 | 3.4 | 3.5 | 4.1 | 4.6 | 4.7 | 4.5 | 3.8 | 5.3 | 4.9 |

| 4.8 | 5.7 | 5.8 | 5.0 | 3.4 | 5.9 | 6.3 | 4.6 | 5.5 | 6.2 |

Neste primeiro exemplo, para fins didáticos, vamos mostrar duas possíveis soluções:

Entramos com os dados com o comando

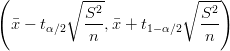

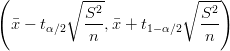

Sabemos que o intervalo de confiança para média de uma distribuição normal com média desconhecida é dado por:

Vamos agora obter a resposta de duas formas diferentes.

Nos comandos a seguir calculamos o tamanho da amostra, a média e a variância amostral.

Com isto podemos montar o intervalo utilizando os quantis da distribuição t.

Mostramos a solução acima para ilustrar a flexibilidade e o uso do programa. Entretanto não precisamos fazer isto na maioria das vezes porque o R já vem com várias funções já disponíveis para procedimentos estatísticos usuais.

Para este exemplo específico a função t.test() pode ser utilizada como vemos no resultado do comando a sequir que coincide com os obtidos anteriormente.

O resultado da função mostra a estimativa obtida da média (19), o intervalo de confiança a 95e testa a igualdade de média a zero (p-value = 1.00642487153941e-14), em um teste bilateral.

Os valores definidos no IC e teste de hipótese acima são defaults que podem ser modificados. Por exemplo, para obter um IC a 99

□

Quando estudamos a relação entre duas variáveis qualitativas em geral fazemos uma tabela com o resultado do cruzamento desta variáveis. Em geral existe interesse em verificar se as variáveis estão associadas e para isto calcula-se uma medida de associação tal como o χ2, coeficiente de contingência C, ou similar. O passo seguinte é testar se existe evidência que a associação é significativa. Uma possível forma de fazer isto é utilizando o teste χ2.

Exemplo Para ilustrar o teste vamos utilizar o conjunto de dados HairEyeColor que já vem disponível com o R. Para carregar e visualizar os dados use os comando abaixo.

Para saber mais sobre estes dados veja help(HairEyeColor) Note que estes dados já vem “resumidos” na forma de uma tabela de frequências tri-dimensional, com cada uma das dimensões correspondendo a um dos atributos - cor dos cabelos, olhos e sexo.

Para ilustrar aqui o teste χ2 vamos verificar se existe associação entre 2 atributos: cor dos olhos e cabelos entre os indivíduos do sexo feminino. Portanto as hipóteses são:

| H0 : | não existe associação |

| Ha : | existe associação |

Vamos adotar α = 5% como nível de significância. Nos comandos abaixo primeiro isolamos apenas a tabela com os indivíduos do sexo masculino e depois aplicamos o teste sobre esta tabela.

O p-value sugere que a associação é significativa. Entretanto este resultado deve ser visto com cautela pois a mensagem de alerta (Warning message) emitida pelo programa chama atenção ao fato de que há várias caselas com baixa frequência na tabela e portanto as condições para a validade do teste não são perfeitamente satisfeitas.

Há duas possibilidades de contornar este problema: a primeira é agrupar categorias na tabela. Uma outra (e usualmente melhor) possibilidade é então usar o p-value calculado por simulação, ao invés do resultado assintótico usado no teste tradicional.

Note que agora a mensagem de alerta não é mais emitida e que a significância foi confirmada (p-valor < 0.05). Note que se voce rodar este exemplo poderá obter um p - value um pouco diferente porque as simulações não necessariamente serão as mesmas.

Lembre-se de inspecionar help(chisq.test) para mais detalhes sobre a implementação deste teste no R.

□

Exemplo Uma certa hipótese genética, se verdadeira deve produzir indivíduos com 4 fenótipos (A, B, C e D) na população seguindo a relação 9:3:3:1. Para verificar se a hipótese genética é plausível foi coletada uma amostra de indivíduos na população e obteve-se o seguinte número de indivíduos para cada fenótipo:

| Fenótipo | A | B | C | D |

| No indivíduos | 190 | 50 | 63 | 20 |

Teste a hipótese de que a hipótese genética é plausível com nível de significância de 5%.

Portanto as hipóteses são:

| H0 : | segue a distribuição esperada |

| Ha : | não segue a distribuição esperada |

O nível de significância foi definido como α = 5% e a estatística de teste χc2 = ∑

i tem

distribuição χ(3)2. Os comandos para efetuar este teste no R são:

tem

distribuição χ(3)2. Os comandos para efetuar este teste no R são:

Portanto a conclusão é que não rejeita-se H0 ao nível de 5%, ou seja, a hipótese genética é plausível.

□

Quando temos duas variáveis quantitativas podemos utilizar o coeficiente de correlação linear de Pearson para medir a associação entre as variáveis, desde que a relação entre elas seja linear.

Exemplo Para ilustrar o teste para o coeficiente linear de Pearson vamos estudar a relação entre o peso e rendimento de carros. Para isto vamos usar as variáveis wt (peso) e mpg (milhas por galão) do conjunto de dados mtcars para testar se existe associação entre estas duas variáveis.

As hipóteses são:

| H0 : | não existe associação (ρ = 0) |

| Ha : | existe associação (ρ≠0) |

Vamos ainda fixar o nivel de significância em 5%. Os comandos para efetuar o teste e os resultados são mostrados a seguir.

Portanto o p-valor acima mostra que a correlação encontrada de -0.867659376517228 difere significativamente de zero, ou seja existe evidência de associação (negativa) entre estas duas variáveis.

OBS: Note que uma análise mais cuidadosa deveria incluir o exame do gráfico entre estas duas variáveis para ver se o coeficiente de correlação linear é adequado para medir a associação.

□

Quando temos uma variável qualitativa com dois níveis e outra quantitativa o interesse em geral está em comparar as médias da quantitativa para cada grupo da qualitativa. Para isto podemos utilizar o testeT. Há diferentes tipos de teste T: para amostras independentes com variâncias iguais ou desiguais, ou para amostras pareadas.

Exemplo Os dados a seguir correspondem a teores de um elemento indicador da qualidade de um certo produto vegetal. Foram coletadas 2 amostras referentes a 2 métodos de produção e deseja-se comparar as médias dos métodos fazendo-se um teste t bilateral, ao nível de 1% de significância e considerando-se as variâncias iguais.

| Método 1 | 0.9 | 2.5 | 9.2 | 3.2 | 3.7 | 1.3 | 1.2 | 2.4 | 3.6 | 8.3 |

| Método 2 | 5.3 | 6.3 | 5.5 | 3.6 | 4.1 | 2.7 | 2.0 | 1.5 | 5.1 | 3.5 |

As hipóteses são:

| H0 : | μ1 = μ2 |

| Ha : | μ1≠μ2 |

Vamos ainda fixar o nivel de significância em 5%. Abaixo os comandos para efetuar o teste bilateral com variâncias iguais.

Os resultados mostram que não há evidências para rejeitar a hipótese de igualdade entre as médias ao nível de 1%.

□

| Machos | 145 | 127 | 136 | 142 | 141 | 137 |

| Fêmeas | 143 | 128 | 132 | 138 | 142 | 132 |

Obtenha intervalos de confiança para a razão das variâncias e para a diferença das médias dos dois grupos.

Dica: Use as funções var.test() e t.test()